A/B-тестування

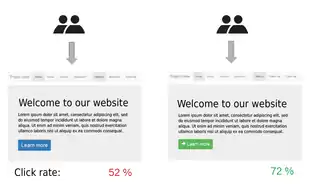

A/B-тестування (англ. A/B testing, Split testing) — метод маркетингового дослідження, суть якого полягає в тому, що контрольна група елементів порівнюється з набором тестових груп, в яких один або декілька показників були змінені, для того, щоб з'ясувати, які зі змін покращують цільовий показник. Хороший приклад — це дослідження впливу колірної схеми, розташування та розміру елементів інтерфейсу на конверсію сайту.[1]

Метод часто використовується при оптимізації веб-сторінок відповідно до заданої мети. Тестуються 2 дуже схожі сторінки (сторінка А і сторінка В), які відрізняються лише одним елементом або декількома елементами (тоді метод називають A/B/N Testing).[2] Сторінки А і В показуються користувачам почергово в рівних пропорціях, при цьому відвідувачі, як правило, не знають про це. По закінченні певного часу або при досягненні певного статистично значимого числа показів порівнюються числові показники мети і визначається найкращий варіант сторінки. До числа компаній, що використовують цей метод, відносяться Amazon і Zynga.

Приклад: рекламна кампанія електронною поштою

Компанія з клієнтами бази даних понад 2000 чоловік вирішує створити електронну кампанію зі знижками в цілях стимулювання продажів через свій вебсайт. Вона створює електронну пошту і потім робить заклик до дії.

До першої 1000 осіб вона відправляє лист із закликом до дії, заявивши «пропозиція закінчується в цю суботу! Використання коду A1», до іншої 1000 осіб вона посилає лист із закликом до дії, заявивши «Обмежена пропозиція! Використовуйте код B1».

Всі інші елементи — копія електронного листа. Потім компанія контролює, яка рекламна кампанія має найвищий показник конверсії на основі аналізу використання промо-кодів. Електронний лист за допомогою коду A1 має 5 % відповідей (50 з 1000 людей електронною поштою використало код, щоб купити продукт), а електронний лист з кодом B1 має 3 % відповідей (30 з 1000 користувачів використали код, щоб купити продукт). Таким чином, компанія вважає, що в цьому випадку, перший заклик до дії є більш ефективним і буде використовувати його в майбутніх рекламних кампаніях.

У наведеному вище прикладі мета випробування — це визначення, який спосіб є найбільш ефективним, щоб змусити клієнта придбати.

A/B-тест повинен мати певний результат, який піддається вимірюванню, наприклад, кількість продажів, число людей, реєстрації і т. ін.

Багато компаній використовують «експериментальний» підхід до прийняття маркетингових рішень. Це стає все більш поширеною практикою, і досвід росте в цій галузі. Є багато A/B-тестувань тематичних досліджень, які показують, що практика тестування стає все більш популярною також у малому і середньому бізнесі[джерело?].

Інструменти для A/B-тестування

Багато інструментів A/B-тестування активно розвиваються. Деякі з них доступні за ліцензією відкритого джерела або безкоштовно:

- Google Analytics Content Experiments (раніше Google Website Optimizer) (на стороні сервера вимагається використання тегів),

- Easy Оптимізатор вебсайтів.

Інші комерційні рішення, як правило, пропонують більш широкий спектр можливостей.

Див.також

Примітки

- Kohavi, Ron; Longbotham, Roger (2015). Online Controlled Experiments and A/B Tests.

- The ABCs of A/B Testing | Salesforce Pardot. Salesforce Pardot (амер.). 12 липня 2012. Процитовано 19 жовтня 2017.