Ймовірнісна нейронна мережа

Ймовірнісна нейронна мережа — вид штучних нейронних мереж, який використовує баєсову статистику для виконання певних завдань. Ймовірнісна нейронна мережа була розроблена Дональдом Спехтом (англ. Donald Specht)[1][2].

Функціонування мережі

Виходи мережі можна інтерпретувати як оцінки ймовірності належності елементу певному класу. Ймовірнісна мережа вчиться оцінювати функцію густини ймовірності, її вихід розглядається як очікуване значення моделі в даній точці простору входів. Це значення пов'язане з густиною ймовірності спільного розподілу вхідних і вихідних даних.

Задача оцінки густини ймовірності відноситься до області баєсової статистики. Звичайна статистика по заданій моделі показує, яка ймовірність того або іншого виходу. Баєсова статистика інтерпретує по-іншому: правильність моделі оцінюється по наявних достовірних даних, тобто надає можливість оцінювати густину ймовірності розподілу параметрів моделі по наявних даних.

При рішенні задач класифікації можна оцінити густину ймовірності для кожного класу, порівняти між собою ймовірності приналежності до різних класів і обрати модель з параметрами, при яких густина ймовірності буде найбільшою.

Оцінка густини ймовірності в мережі заснована на ядерних оцінках. Якщо приклад розташований в даній точці простору, тоді в цій точці є певна густина ймовірності. Кластери з близько розташованих точок свідчать, що в цьому місці густина ймовірності велика. Поблизу спостереження є більша довіра до рівня густини, а по мірі віддалення від нього довіра зменшується і плине до нуля. В методі ядерних оцінок в точку, що відповідає кожному прикладу, поміщається деяка проста функція, потім вони всі додаються і в результаті утворюється оцінка для загальної густини ймовірності. Найчастіше як ядерні функції беруть дзвоноподібні функції (гаусові). Якщо є достатня кількість навчальних прикладів, такий метод дає добрі наближення до істинної густини ймовірності.

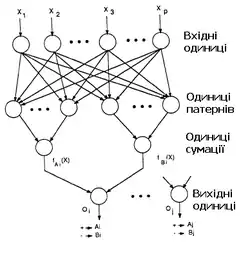

Архітектура мережі

Ймовірнісна мережа має три прошарки: вхідний, радіальний та вихідний. Радіальні елементи беруться по одному на кожний приклад. Кожний з них містить гаусову функцію з центром в цьому прикладі. Кожному класу відповідає один вихідний елемент. Вихідний елемент з'єднаний лише з радіальними елементами, що відносяться до його класу і підсумовує виходи всіх елементів, що належать до його класу. Значення вихідних сигналів утворюються пропорційно ядерних оцінок ймовірності приналежності відповідним класам.

Модифікації

Базова модель ймовірнісної мережі має модифікації. Припустимо, що пропорції класів у навчальній множині відповідають їх пропорціям у всій досліджуваній вибірці (апріорна ймовірність). Наприклад, якщо серед всіх людей хворими є 2%, то в навчальній множині для мережі, яка діагностує захворювання, хворих також повинно бути 2%. Якщо ж апріорні ймовірності відрізняються від пропорції в навчальній виборці, мережа буде видавати невірний результат. Це можна врахувати, вводячи корегуючі коефіцієнти для різноманітних класів.

Переваги та недоліки

Навчання ймовірнісної нейронної мережі є набагато простішим, ніж метод зворотного поширення помилки. Істотним недоліком мережі є її розмір, оскільки вона фактично вміщує в собі всі навчальні дані, потребує багато пам'яті і може повільно працювати.

Література

- http://www.inf.ufrgs.br/~engel/Common/CMP121/PNN.pdf%5Bнедоступне+посилання+з+липня+2019%5D Donald Specht Probabilistic Neural Networks for Classification, 1988

- Donald Specht Mapping or Associative Memory and Probabilistic Neural Networks, 1990