Спільна ентропія

У теорії інформації спі́льна ентропі́я — це міра невизначеності, пов'язана з набором змінних.

| Теорія інформації |

|---|

|

|

|

|

Визначення

Спільна ентропія Шеннона (в бітах) двох змінних та визначається як

де та є конкретними значеннями та відповідно, є спільною ймовірністю трапляння цих значень разом, а визначається як 0, якщо .

Для понад двох змінних це визначення розширюється до

де є конкретними значеннями відповідно, є ймовірністю трапляння цих значень разом, а визначається як 0, якщо .

Властивості

Більша за окремі ентропії

Спільна ентропія набору змінних є більшою за всі окремі ентропії змінних цього набору, або дорівнює їм.

Менша або дорівнює сумі окремих ентропій

Спільна ентропія набору змінних є меншою за суму окремих ентропій змінних цього набору, або дорівнює їй. Це є прикладом субадитивності. Ця нерівність є рівністю, якщо і лише якщо та є статистично незалежними.

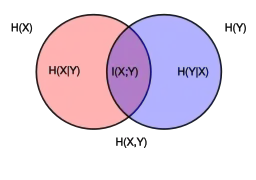

Відношення до інших мір ентропії

Спільна ентропія використовується у визначенні умовної ентропії

- ,

і

Вона також використовується у визначенні взаємної інформації

У квантовій теорії інформації спільна ентропія узагальнюється до квантової спільної ентропії.

Джерела

- Theresa M. Korn; Korn, Granino Arthur. Mathematical Handbook for Scientists and Engineers: Definitions, Theorems, and Formulas for Reference and Review. New York: Dover Publications. с. 613–614. ISBN 0-486-41147-8. (англ.)