Оцінка апостеріорного максимуму

Оці́нка ма́ксимуму апостеріо́рної імові́рності (МАІ, англ. maximum a posteriori probability estimate, MAP) у баєсовій статистиці — це мода апостеріорного розподілу. МАІ може застосовуватися для отримання точкової оцінки неспостережуваної величини на базі емпіричних даних. Вона є тісно пов'язаною з методом максимальної правдоподібності (МП, англ. maximum likelihood, ML) Фішера, але застосовує розширену цільову функцію, що включає апріорний розподіл оцінюваної величини. Таким чином, МАІ можна розглядати як регуляризацію оцінки МП.

| Частина з циклу Статистика |

| Баєсова статистика |

|---|

| Теорія |

|

| Методи |

Опис

Припустімо, що ми хочемо оцінити неспостережуваний параметр розподілу на базі спостережень . Нехай буде вибірковим розподілом , так що є ймовірністю , коли підлеглий параметр розподілу є . Тоді функція

є відомою як функція правдоподібності, а оцінка

є оцінкою максимальної правдоподібності .

Тепер припустімо, що існує апріорний розподіл , . Це дозволяє нам розглядати як випадкову змінну в баєсовій статистиці. Тоді апостеріорний розподіл є наступним:

де є функцією густини , а є областю визначення . Це є прямим застосуванням теореми Баєса.

Відтак метод оцінки апостеріорного максимуму оцінює як моду апостеріорного розподілу цієї випадкової змінної:

Знаменник цього апостеріорного розподілу (так звана статистична сума) не залежить від , і тому не відіграє ролі в оптимізації. Зверніть увагу, що коли апріорне є рівномірним (тобто сталою функцією), то оцінка МАІ збігається з оцінкою МП. І що коли функція втрат має вигляд

та прямує до 0, то послідовність баєсових оцінок наближається до оцінювача МАІ, за умови, що розподіл є одномодовим. Але в цілому оцінювач МАІ не є баєсовим оцінювачем, хіба що якщо є дискретною.

Обчислення

Оцінку МАІ може було обчислювано кількома шляхами:

- Аналітичним, коли моду (моди) апостеріорного розподілу може бути задано в замкненій формі. Це той випадок, коли застосовуються спряжені апріорні.

- Шляхом чисельної оптимізації, такої як метод спряжених градієнтів або метод Ньютона. Це зазвичай вимагає перших або других похідних, що має бути виражено чи то аналітично, чи то чисельно.

- Шляхом видозміни алгоритму очікування-максимізації. Це не вимагає похідних апостеріорної густини.

- Методом Монте-Карло із застосуванням імітації відпалу.

Критика

Хоча оцінка МАІ і є границею баєсових оцінок (при функції втрат 0-1), вона не є типовим представником баєсових методів у цілому. Причина в тому, що оцінки МАІ є точковими, тоді як баєсові методи характеризуються використанням розподілів для підсумовування даних та видачі висновків: так, баєсові методи тяжіють замість цього до повідомлення апостеріорного середнього або медіани разом із імовірними інтервалами. В обох випадках причиною є те, що ці оцінки є оптимальними при втратах із квадратичною або лінійною помилкою відповідно, — а вони є характернішими представниками типових функцій втрат, — і те, що апостеріорний розподіл може не мати простої аналітичної форми: в такому випадку цей розподіл може бути симульовано за допомогою методик Монте-Карло марковських ланцюгів, тоді як оптимізація для пошуку цієї моди (мод) може бути складною, або неможливою.[джерело?]

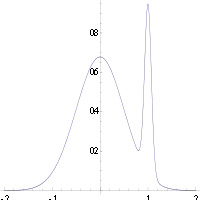

У багатьох типах моделей, як наприклад сумішевих, апостеріорне може бути бімодальним. У такому разі звичною порадою є обирати найвищу моду: це не завжди є прийнятним (глобальна оптимізація є складною задачею), а в деяких випадках навіть і неможливим (як при виникненні проблем ідентифіковності). До того ж, найвища мода може бути не характерною для більшості апостеріорного.

Нарешті, на відміну від оцінок МП, оцінка МАІ не є інваріантною відносно параметризації. Перемикання з однієї параметризації на іншу включає введення якобіану, що впливає на положення максимуму.[1]

Як приклад різниці між згаданими вище баєсовими оцінками (середнього та медіани) та використанням оцінки МАІ, розгляньмо випадок, коли необхідно класифікувати входи як або позитивні, або негативні (наприклад, позички як ризиковані або безпечні). Припустімо, що існує лише три можливі гіпотези правильного методу класифікації, , and , з апостеріорними 0.4, 0.3 та 0.3 відповідно. Припустімо, що заданий новий зразок гіпотеза класифікує як позитивний, тоді як дві інші — як негативний. При застосуванні оцінки МАІ для точного класифікатора , класифікується як позитивний, тоді як баєсові оцінки зробили би усереднення над усіма гіпотезами, та класифікували би як негативний.

Приклад

Припустімо, що нам дано послідовність незалежних однаково розподілених випадкових змінних та апріорний розподіл , заданий . Ми хочемо отримати оцінку МАІ .

Функцію, що потрібно максимізувати, задано як

що є еквівалентним мінімізації наступної функції :

Отже, ми бачимо, що оцінка МАІ для μ задається як

що виявляється лінійною інтерполяцією середнього апріорного та середнього вибірки, зважену за їхніми відповідними коваріаціями.

Випадок називається неінформативним апріорним, і веде до недовизначеного апріорного розподілу ймовірності; в цьому випадку

Посилання

- Murphy, Kevin P. (2012). Machine learning : a probabilistic perspective. Cambridge, MA: MIT Press. с. 151–152. ISBN 0262018020. (англ.)

Джерела

- M. DeGroot, Optimal Statistical Decisions, McGraw-Hill, (1970). (англ.)

- Harold W. Sorenson, (1980) "Parameter Estimation: Principles and Problems", Marcel Dekker. (англ.)