Баєсова лінійна регресія

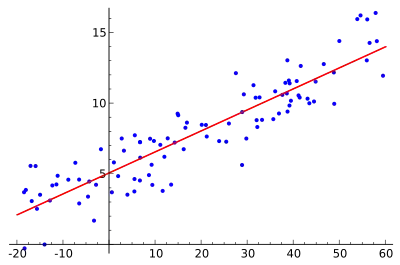

Ба́єсова ліні́йна регре́сія в статистиці — це підхід до лінійної регресії, в якому статистичний аналіз застосовується в контексті баєсового висновування. Якщо помилки регресійної моделі мають нормальний розподіл і якщо розглядається певна форма апріорного розподілу, то для апостеріорного розподілу ймовірності параметрів моделі доступні точні результати.

| Частина з циклу Статистика |

| Баєсова статистика |

|---|

| Теорія |

|

| Методи |

| Частина з циклу Статистика |

| Регресійний аналіз |

|---|

|

| Моделі |

|

|

|

|

|

| Оцінка |

|

|

| Підґрунтя |

|

Налаштування моделі

Розгляньмо стандартну задачу лінійної регресії, в якій для ми вказуємо умовну ймовірність для заданого вектора провісників :

де є вектором завдовжки , а є незалежними однаково розподіленими випадковими величинами з нормальним розподілом:

Це відповідає такій функції правдоподібності:

Розв'язком звичайних найменших квадратів є оцінка вектора коефіцієнтів за допомогою псевдообернення Мура-Пенроуза:

де є матрицею плану , кожен з рядків якої є вектором провісників , а є вектором-стовпцем .

Це є частотним підходом, що передбачає наявність достатньої кількості вимірювань, щоби сказати щось суттєве про . За баєсового ж підходу дані надаються з додатковою інформацією у вигляді апріорного розподілу ймовірності. Ці апріорні переконання про параметри поєднуються з функцією правдоподібності даних згідно з теоремою Баєса для отримання апостеріорного переконання про параметри та . Це апріорне може мати різний функціональний вигляд в залежності від області визначення та інформації, що доступна апріорі.

Зі спряженими апріорними

Спряжений апріорний розподіл

Для довільного апріорного розподілу може не існувати аналітичного розв'язку задачі пошуку апостеріорного розподілу. В цьому розділі ми розглянемо так зване спряжене апріорне, для якого апостеріорний розподіл може бути виведено аналітично.

Апріорне є спряженим до функції правдоподібності, якщо вона має такий самий функційний вигляд по відношенню до та . Оскільки логарифмічна правдоподібність є квадратичною в , логарифмічна правдоподібність переписується так, що правдоподібність стає нормальною в . Запишімо

Логарифмічна правдоподібність тепер переписується як

де

- та

де є кількістю коефіцієнтів регресії.

Це підказує такий вигляд апріорного:

де є оберненим гамма-розподілом

У записі, запропонованому в статті про обернений гамма-розподіл, це є густиною розподілу з та з та як апріорних значень та відповідно. Рівносильно, це також може бути описано як зважений обернений розподіл хі-квадрат,

Далі густина умовного апріорного є нормальним розподілом,

У записі нормального розподілу густина умовного апріорного є

Апостеріорний розподіл

Із вже визначеним апріорним, апостеріорний розподіл може бути виражено як

За певного переформулювання[1] апостеріорне може бути переписано так, що апостеріорне середнє вектора параметрів може бути виражено в термінах оцінки найменших квадратів та апріорного середнього , де підтримка апріорного вказується матрицею точності апріорного

Для підтвердження того, що дійсно є апостеріорним середнім, квадратні члени в експоненті може бути переформульовано як квадратичну форму в .[2]

Тепер апостеріорне може бути виражено як добуток нормального розподілу на обернений гамма-розподіл:

Отже, апостеріорний розподіл може бути параметризовано таким чином.

де ці два множники відповідають густинам розподілів та , з їхніми параметрами, що задаються як

Це може інтерпретуватися як баєсове навчання, де параметри уточнюються відповідно до наступних рівнянь.

Свідчення моделі

Свідчення моделі є ймовірністю даних за заданої моделі . Воно також відоме як відособлена правдоподібність, а також як передбачувана апріорна густина. Тут модель визначається функцією правдоподібності та апріорним розподілом параметрів, тобто, . Свідчення моделі фіксує одним числом, наскільки гарно така модель пояснює ці спостереження. Свідчення моделі баєсової лінійної регресії, представлене в цьому розділі, може застосовуватись для порівняння конкурентних лінійних моделей баєсовим порівнянням моделей. Ці моделі можуть відрізнятися як кількістю та значеннями змінних-провісників, так і своїми апріорними параметрами моделі. Складність моделі вже враховано свідченням моделі, оскільки воно відособлює параметри інтегруванням над усіма можливими значеннями та .

Цей інтеграл може бути обчислено аналітично, а розв'язок представлено наступним рівнянням.[3]

Тут позначає гамма-функцію. Оскільки ми обрали спряжене апріорне, то відособлену правдоподібність також може бути легко обчислено розв'язанням наступного рівняння для довільних значень та .

Зауважте, що це рівняння є ні чим іншим, як переформулюванням теореми Баєса. Підставлення формул для апріорного, правдоподібності та апостеріорного, та спрощення отримуваного виразу ведуть до аналітичного виразу, наведеного вище.

Інші випадки

Виводити апостеріорний розподіл аналітично в загальному випадку може бути неможливо або непрактично. Проте можливо наближувати апостеріорне методом приблизного баєсового висновування, таким як вибірка Монте-Карло[4] або варіаційні баєсові методи.

Особливий випадок називається гребеневою регресією.

Схожий аналіз може виконуватись для загального випадку багатовимірної регресії, і його частина забезпечує баєсову оцінку коваріаційних матриць: див. багатовимірну баєсову лінійну регресію.

Див. також

- Баєсова лінійна статистика

- Регуляризація Тихонова

Примітки

- Проміжні кроки цього обчислення може бути знайдено в O'Hagan (1994) на початку розділу про лінійні моделі.

- Проміжні кроки є в Fahrmeir et al. (2009) на С. 188.

- Проміжні кроки цього обчислення можна знайти в O'Hagan (1994) на С. 257.

- Carlin and Louis(2008) and Gelman, et al. (2003) пояснюють, як використовувати вибіркові методи для баєсової лінійної регресії.

Джерела

- Box, G. E. P.; Tiao, G. C. (1973). Bayesian Inference in Statistical Analysis. Wiley. ISBN 0-471-57428-7. (англ.)

- Carlin, Bradley P. and Louis, Thomas A. (2008). Bayesian Methods for Data Analysis, Third Edition. Boca Raton, FL: Chapman and Hall/CRC. ISBN 1-58488-697-8. (англ.)

- O'Hagan, Anthony (1994). Bayesian Inference. Kendall's Advanced Theory of Statistics 2B (вид. First). Halsted. ISBN 0-340-52922-9. (англ.)

- Gelman, Andrew, Carlin, John B., Stern, Hal S. and Rubin, Donald B. (2003). Bayesian Data Analysis, Second Edition. Boca Raton, FL: Chapman and Hall/CRC. ISBN 1-58488-388-X. (англ.)

- Walter Gero. Bayesian Linear Regression—Different Conjugate Models and Their (In)Sensitivity to Prior-Data Conflict. — 2009. (англ.)

- Goldstein, Michael; Wooff, David (2007). Bayes Linear Statistics, Theory & Methods. Wiley. ISBN 978-0-470-01562-9. (англ.)

- Fahrmeir, L., Kneib, T., and Lang, S. (2009). Regression. Modelle, Methoden und Anwendungen (вид. Second). Heidelberg: Springer. ISBN 978-3-642-01836-7. doi:10.1007/978-3-642-01837-4. (англ.)

- Rossi, Peter E.; Allenby, Greg M.; McCulloch, Robert (2006). Bayesian Statistics and Marketing. John Wiley & Sons. ISBN 0470863676. (англ.)

- Thomas P. Minka (2001) Bayesian Linear Regression, Microsoft research web page (англ.)

Посилання

- Bayesian estimation of linear models (R programming wikibook). Реалізація баєсової лінійної регресії мовою R.