Баєсове висновування

Ба́єсове висно́вування[1][2] (англ. Bayesian inference) — це метод статистичного висновування, за яким для уточнення ймовірності гіпотези при отриманні додаткових свідчень або інформації застосовують правило Баєса. Баєсове висновування є важливим прийомом у статистиці, особливо в математичній. Баєсове уточнення є особливо важливим у динамічному аналізі послідовностей даних. Баєсове висновування знайшло застосування в широкому діапазоні галузей, включно із наукою, інженерією, філософією, медициною, спортом та правом. У філософії теорії рішень баєсове висновування тісно пов'язано із суб'єктивною ймовірністю, що її часто називають «баєсовою ймовірністю».

| Частина з циклу Статистика |

| Баєсова статистика |

|---|

| Теорія |

|

| Методи |

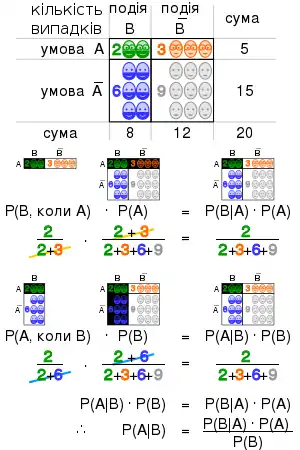

Введення до правила Баєса

Формальне тлумачення

Баєсове висновування виводить апостеріорну ймовірність як логічний наслідок двох передумов, апріорної ймовірності та «функції правдоподібності», виведеної зі статистичної моделі спостережуваних даних. Баєсове висновування обчислює апостеріорну ймовірність відповідно до теореми Баєса:

де

- позначає «подія за умови» (таким чином, означає A за умови B).

- означає будь-яку гіпотезу (англ. hypothesis), на чию ймовірність можуть вплинути дані (що називаються нижче свідченням). Часто існують конкуруючі гіпотези, і задача полягає у визначенні того, яка з них є найімовірнішою.

- , апріорна ймовірність, є оцінкою ймовірності гіпотези до спостереження даних , поточного свідчення.

- свідчення (англ. evidence) відповідає новим даним, що не використовувалися при обчисленні апріорної ймовірності.

- , апостеріорна ймовірність, є ймовірністю за умови , тобто, після спостереження . Вона є тим, що ми хочемо знати: ймовірністю гіпотези за умови отриманого свідчення.

- є ймовірністю спостереження за умови , і її називають правдоподібністю. Як функція від при незмінній , вона вказує на сумісність свідчення з даною гіпотезою. Функція правдоподібності є функцією від свідчення, , тоді як апостеріорна ймовірність є функцією від гіпотези, .

- іноді називають відособленою правдоподібністю, або «свідченням моделі». Цей множник є однаковим для всіх можливих гіпотез, що розглядаються (що очевидно з того факту, що гіпотеза ніде не з'являється в цьому позначенні, на відміну від усіх інших множників), тож цей множник не входить до визначення відносних ймовірностей різних гіпотез.

Для різних значень на значення впливають лише множники та , обидва в чисельнику, — апостеріорна ймовірність гіпотези є пропорційною її апріорній ймовірності (притаманній їй вірогідності) та новоотриманій правдоподібності (її сумісності з новим спостереженим свідченням).

Правило Баєса також може бути записано наступним чином:

де множник можна інтерпретувати як вплив на ймовірність .

Альтернативи баєсовому уточненню

Баєсове уточнення широко застосовується та є обчислювально зручним. Однак, це не єдине правило уточнення, що може вважатися раціональним.

Ян Хакінг зауважив, що традиційні аргументи голландської системи ставок не визначали використання саме баєсового уточнення: вони залишили відкритою можливість, що не-баєсові правила уточнення можуть обходити голландську систему ставок. Хакінг написав:[3]

| Й ані аргумент голландської системи ставок, ані жоден інший в арсеналі доказів ймовірнісних аксіом персоналістів не тягне за собою динамічного припущення. Жоден не тягне за собою баєсовизму. Тому персоналістові потрібно, щоби динамічне припущення було баєсовим. Це є правда, що в послідовності персоналіст може відмовитися від байєсової моделі навчання на досвіді. Сіль може втратити свій смак.

Оригінальний текст (англ.) And neither the Dutch book argument nor any other in the personalist arsenal of proofs of the probability axioms entails the dynamic assumption. Not one entails Bayesianism. So the personalist requires the dynamic assumption to be Bayesian. It is true that in consistency a personalist could abandon the Bayesian model of learning from experience. Salt could lose its savour. |

Дійсно, існують не-баєсові правила уточнення, що також обходять голландську систему ставок (як обговорюється в літературі про «кінематику ймовірностей») після публікації правила Річарда Джефрі, що застосовує правило Баєса до випадку, коли свідченню самому встановлюється ймовірність.[4] Додаткові гіпотези, необхідні для однозначної вимоги баєсового уточнення, було визнано значними, складними та незадовільними.[5]

Формальний опис баєсового висновування

Позначення

- , точка даних у загальному сенсі. Фактично це може бути вектор значень.

- , параметр розподілу точки даних, тобто, . Фактично це може бути вектор параметрів.

- , гіперпараметр розподілу параметра, тобто, . Фактично це може бути вектор гіперпараметрів.

- є вибіркою, набором спостережуваних точок даних, тобто, .

- , нова точка даних, чий розподіл потрібно передбачити.

Баєсове висновування

- Апріорний розподіл — це розподіл параметру (параметрів) до будь-якого спостереження даних, тобто .

- Визначити апріорний розподіл може бути не так легко. У даному випадку ми можемо скористатися апріорним розподілом Джеффріса, щоби отримати апостеріорний розподіл перед уточненням його подальшими спостереженнями.

- Вибірковий розподіл — це розподіл спостережуваних даних в залежності від його параметрів, тобто, . Його також називають функцією правдоподібності (англ. likelihood function), особливо коли розглядають його як функцію від параметру (параметрів), що іноді записується як .

- Відособлена правдоподібність (що іноді також називають свідченням) — це розподіл спостережуваних даних, відособлений за параметром (параметрами), тобто, .

- Апостеріорний розподіл — це розподіл параметру (параметрів) після взяття до уваги спостережуваних даних. Він визначається за правилом Баєса, що формує серцевину баєсового висновування:

Зауважте, що словами це виражається як «апостеріорне є пропорційним апріорному, помноженому на правдоподібність», або іноді як «апостеріорне = правдоподібність на апріорне, відносно свідчення».

Баєсове передбачування

- Апостеріорний передбачуваний розподіл — це розподіл нової точки даних, відособлений за апостеріорним:

- Апріорний передбачуваний розподіл — це розподіл нової точки даних, відособлений за апріорним:

Баєсова теорія передбачає використання апостеріорного передбачуваного розподілу для передбачувального висновування, тобто, для передбачування розподілу ймовірностей нової, ще не спостережуваної точки даних. Тобто, замість фіксованої точки, як передбачення повертається розподіл ймовірностей над можливими точками. Лише в цьому випадку є повний апостеріорний розподіл параметру (параметрів), що використовуються. Для порівняння, передбачування у частотній статистиці часто полягає у знаходженні оптимальної точкової оцінки параметру (параметрів) — наприклад, методом максимальної правдоподібності або оцінки апостеріорного максимуму — і наступному підставленні цієї оцінки до формули розподілу точки даних. Це має той недолік, що воно не враховує жодної невизначеності у значенні параметру, і відтак недооцінюватиме дисперсію передбачуваного розподілу.

(У деяких випадках частотна статистика може обходити цю проблему. Наприклад, коли довірчі та передбачувані інтервали у частотній статистиці будуються з нормального розподілу з невідомим середнім значенням та дисперсією, вони будуються з використанням t-розподілу Стьюдента. Це дає правильну оцінку дисперсії завдяки тому факту, що (1) середнє значення випадкових величин із нормальним розподілом також має нормальний розподіл; (2) передбачуваний розподіл точки даних з нормальним розподілом та невідомими середнім значенням та дисперсією при використанні спряжених або неінформативних апріорних розподілів має t-розподіл Стьюдента. Однак, у баєсовій статистиці апостеріорний передбачуваний розподіл може завжди визначатися точно — чи, принаймні, з довільним рівнем точності, при застосуванні чисельних методів.)

Зауважте, що обидва типи передбачуваних розподілів мають вигляд складного розподілу ймовірності (так само, як і відособлена правдоподібність). Справді, якщо апріорний розподіл є спряженим апріорним розподілом, і, отже, апріорний та апостеріорний розподіли походять із одного сімейства, то можна легко переконатися, що як апріорний, так і апостеріорний передбачувані розподіли також походять з одного й того ж сімейства складних розподілів. Різниця лише в тім, що апостеріорний передбачуваний розподіл використовує уточнені значення гіперпараметрів (застосовуючи баєсові правила уточнення, наведені у статті про спряжений апріорний розподіл), тоді як апріорний передбачуваний розподіл використовує значення гіперпараметрів, що фігурують в апріорному розподілі.

Висновування над взаємовиключними вичерпними можливими значеннями

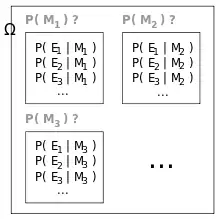

Якщо свідчення використовується для одночасного уточнення переконань над набором взаємовиключних вичерпних можливих значень, то баєсове висновування можна розглядати як таке, що діє над розподілом цих переконань у цілому.

Загальне формулювання

Припустімо, що процес породжує незалежні однаково розподілені події (англ. events) , але розподіл ймовірностей є невідомим. Нехай простір подій представляє поточний стан переконань для цього процесу. Кожну модель представляють подією . Для визначення моделей вказують умовні ймовірності . є мірою переконання в . Перед першим кроком висновування є набором початкових апріорних ймовірностей. Вони повинні в сумі давати 1, а в іншому можуть бути довільними.

Припустімо, що ми спостерігали, що процес породив . Для кожної апріорна уточнюється до апостеріорної . З теореми Баєса:[6]

Після спостереження подальших свідчень цю процедуру може бути повторено.

Кілька спостережень

Для послідовності незалежних однаково розподілених спостережень за допомогою індукції може бути показано, що повторне застосування наведеного вище еквівалентне

де

Для послідовності, в якій умовну незалежність спостережень гарантовано бути не може, Рейчел Бонд, Ян-Хуей Хе та Томас Ормерод[7] показали з квантової механіки, що

отже,

Параметричне формулювання

При параметризації простору моделей переконання в усіх моделях можуть уточнюватися за один крок. Розподіл переконань над простором моделей може розглядатися як розподіл переконань над простором параметрів. Розподіли в цьому розділі виражаються як безперервні, представлені густинами імовірності, як це й є у звичайній ситуації. Тим не менше, ця методика є так само застосовною й до дискретних розподілів.

Нехай вектор охоплює простір параметрів. Нехай початковим апріорним розподілом над буде , де є набором параметрів самого апріорного розподілу, або гіперпараметрів. Нехай буде послідовністю незалежних однаково розподілених спостережень подій, де всі розподілено як для деякого . Для отримання апостеріорного розподілу над застосовується теорема Баєса:

де

Математичні властивості

Інтерпретація множника

. Тобто, якщо модель була вірною, то свідчення буде правдоподібнішим, ніж передбачено поточним станом переконання. Зворотня ситуація веде до зменшення переконання. Якщо переконання не змінюється, то . Тобто, свідчення не залежить від моделі. Якщо модель була вірною, то свідчення буде правдоподібним рівно настільки, наскільки передбачено поточним станом переконання.

Правило Кромвеля

Детальніші відомості з цієї теми ви можете знайти в статті Правило Кромвеля.

Якщо , то . Якщо , то . Це може інтерпретуватися так, що категоричні переконання є нечутливими до контр-доказів.

Перше випливає безпосередньо з теореми Баєса. Друге може бути виведено застосуванням першого правила до події «не » замість «», що дасть «якщо , то », з чого результат випливатиме безпосередньо.

Асимптотична поведінка апостеріорного розподілу

Розгляньмо поведінку розподілу переконання у процесі його уточнення велику кількість разів незалежними однаково розподіленими пробами. Для достатньо гарних апріорних ймовірностей теорема Бернштайна — фон Мізеса дає те, що на границі нескінченних проб апостеріорний розподіл збігається до нормального, незалежно від початкового апріорного розподілу, за певних умов, вперше окреслених та суворо доведених Джозефом Дубом 1948 року, а саме, якщо випадкова змінна у міркуваннях має скінченний імовірнісний простір. Загальніші результати було отримано пізніше статистиком Девідом Фрідменом, який опублікував у двох плідних дослідницьких працях 1963[8] та 1965[9] років, коли і за яких обставин гарантується асимптотична поведінка апостеріорного розподілу. Його праця 1963 року, як і праця Дуба 1949 року, розглядає скінченний випадок, і приходить до задовільного результату. Однак, якщо випадкова змінна має нескінченний, але зліченний імовірнісний простір (тобто, відповідає гральній кістці з нескінченною кількістю граней), то праця 1965 року демонструє, що для щільної підмножини апріорних ймовірностей теорема Бернштайна — фон Мізеса не є застосовною. В цьому випадку асимптотичного збігання майже напевно немає. Пізніше у 1980-х та 1990-х роках Девід Фрідмен та Персі Діаконіс продовжили працювати над випадком нескінченних зліченних імовірнісних просторів.[10] Підсумовуючи, для подолання впливу початкового вибору може бути замало проб, і, особливо у випадку великих (але скінченних) систем, збігання може бути дуже повільним.

Спряжені апріорні розподіли

Детальніші відомості з цієї теми ви можете знайти в статті Спряжений апріорний розподіл.

У параметризованій формі часто вважається, що апріорний розподіл належить до сімейства розподілів, що називається спряженими апріорними розподілами. Корисність спряженого апріорного розподілу полягає в тім, що відповідний апостеріорний розподіл належатиме до того ж сімейства, і його обчислення може бути виражено у замкненому вигляді.

Оцінки параметрів та передбачень

Часто потрібно використовувати апостеріорний розподіл для оцінювання параметру або змінної. Кілька методів баєсового оцінювання вибирають вимірювання центральної тенденції з апостеріорного розподілу.

Для одновимірних задач існує унікальна медіана для практичних безперервних задач. Апостеріорна медіана є привабливою як робастний оцінювач.[11]

Якщо для апостеріорного розподілу існує скінченне середнє значення, тоді апостеріорне середнє є методом оцінювання.[12]

Взяття значення із найбільшою ймовірністю визначає оцінки апостеріорного максимуму (англ. maximum a posteriori, MAP):[13]

Існують приклади, в яких не досягається жодного максимуму, і в такому випадку множина оцінок апостеріорного максимуму є порожньою.

Існують інші методи оцінювання, що мінімізують апостеріорний ризик (очікувані апостеріорні втрати) відносно функції втрат, і вони становлять інтерес для статистичної теорії рішень з використанням вибіркового розподілу («частотна статистика»).[14]

Апостеріорний передбачуваний розподіл нового спостереження (що є незалежним від попередніх спостережень) визначається як

Приклади

Ймовірність гіпотези

Припустімо, є дві повні чаші коржиків. Чаша № 1 містить 10 шоколадних коржиків, і 30 звичайних, тоді як чаша № 2 містить по 20 кожних. Наш друг Петро обирає випадкову чашу, й витягає з неї випадковий коржик. Ми можемо припустити, що немає жодних підстав вважати, що Петро віддає перевагу якійсь із чаш, і аналогічно з коржиками. Коржик виявляється звичайним. Якою є ймовірність того, що Петро взяв його з чаші № 1?

Інтуїтивно здається ясним, що відповідь повинна бути більшою за половину, оскільки простих коржиків у чаші № 1 більше. А точну відповідь дає теорема Баєса. Нехай відповідає чаші № 1, а — чаші № 2. Дано, що з точки зору Петра вони є ідентичними, отже, , і в сумі вони повинні давати 1, тому обидва дорівнюють 0.5. Подія є спостереженням звичайного коржика. Із вмісту чаш нам відомо, що і . Формула Баєса відтак дає

До того, як ми побачили коржик, ймовірність, яку ми призначили виборові Петром чаші № 1, була апріорною ймовірністю, , що дорівнювала 0.5. Після спостереження того коржика ми мусимо переглянути ймовірність до , що дорівнює 0.6.

Здійснення передбачування

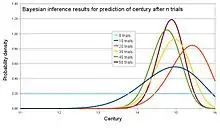

Археолог працює на розкопках поселення припусти́мо середньовічного періоду, між XI та XVI століттями. Тим не менш, залишається не ясним, коли саме протягом цього періоду поселення було заселеним. Знайдено уламки кераміки, деякі з них глазуровані, і деякі розписні. Очікується, що якщо поселення було заселеним протягом раннього середньовіччя, то 1 % кераміки буде глазурованим, і 50 % його поверхні буде розписано, тоді як якщо воно було заселеним пізнього середньовіччя, то 81 % буде глазурованим, і 5 % його площі буде розписано. Наскільки впевненим може бути археолог у даті заселення у процесі викопування уламків?

Необхідно обчислювати міру переконання у безперервній змінній (століття), маючи дискретний набір подій (де — глазурованість, а — наявність розпису) як свідчення. Припускаючи лінійну зміну глазурованості та розпису протягом часу та те, що ці змінні є незалежними,

Припустімо, що апріорним є неперервний рівномірний розподіл , і що проби є незалежними однаково розподіленими. Коли виявляється новий уламок типу , застосовується теорема Баєса для уточнення міри переконання у кожному :

На графіку зображено комп'ютерну симуляцію зміни переконання в процесі викопування 50 уламків. У цій симуляції поселення було заселено близько 1420 року, або . За допомогою обчислення площі під відповідною частиною цього графіка для 50 проб археолог може стверджувати, що практично немає шансів, що це поселення було заселеним в XI та XII століттях, близько 1 % складає шанс того, що воно було заселеним протягом XIII століття, 63 % шансів протягом XIV століття та 36 % протягом XV століття. Зауважте, що теорема Бернштайна — фон Мізеса стверджує, що тут має місце асимптотичне збігання до «справжнього» розподілу, оскільки ймовірнісний простір, що відповідає дискретному наборові подій , є скінченним (див. вище розділ про асимптотичну поведінку апостеріорного розподілу).

У частотній статистиці та теорії рішень

Обґрунтування використання баєсового висновування в теорії рішень було зроблено Абрахамом Вальдом, який довів, що будь-яка унікальна баєсова процедура є прийнятною. І навпаки, кожна прийнятна статистична процедура є або баєсовою процедурою, або границею баєсових процедур.[15]

Валд охарактеризував прийнятні процедури як баєсові процедури (та границі баєсових процедур), зробивши баєсів формалізм центральною методикою в таких галузях частотного висновування як оцінювання параметрів, перевірка гіпотез та обчислення довірчих інтервалів.[16][17][18] Наприклад:

| За певних умов усі прийнятні процедури є або баєсовими процедурами, або границями баєсових процедур (у різних сенсах). Ці видатні результати, принаймні в їх оригінальному вигляді, належать по суті Валдові. Вони корисні, бо властивість баєсовості аналізувати простіше, ніж властивість прийнятності.[15]

Оригінальний текст (англ.) Under some conditions, all admissible procedures are either Bayes procedures or limits of Bayes procedures (in various senses). These remarkable results, at least in their original form, are due essentially to Wald. They are useful because the property of being Bayes is easier to analyze than admissibility. |

| У теорії рішень досить загальний метод доведення прийнятності полягає у демонстрації того, що процедура є унікальним баєсовим розв'язком.[19]

Оригінальний текст (англ.) In decision theory, a quite general method for proving admissibility consists in exhibiting a procedure as a unique Bayes solution. |

| У перших розділах цієї праці апріорні розподіли зі скінченним носієм та відповідні баєсові процедури застосовувалися для запроваджування деяких з головних теорем, пов'язаних із порівнянням експериментів. Баєсові процедури по відношенню до загальніших апріорних розподілів відіграли дуже важливу роль у розвитку статистики, включно з її асимптотичною теорією.[20]

Оригінальний текст (англ.) In the first chapters of this work, prior distributions with finite support and the corresponding Bayes procedures were used to establish some of the main theorems relating to the comparison of experiments. Bayes procedures with respect to more general prior distributions have played a very important role in the development of statistics, including its asymptotic theory. |

| Існує багато задач, де побіжний погляд на апостеріорні розподіли, за підхожих апріорних, негайно дає цікаву інформацію. Цього методу також важко уникнути у послідовному аналізі.[20]

Оригінальний текст (англ.) There are many problems where a glance at posterior distributions, for suitable priors, yields immediately interesting information. Also, this technique can hardly be avoided in sequential analysis. |

| Корисним фактом є те, що баєсове правило рішення, отримане взяттям належного апріорного розподілу над усім простором параметрів, мусить бути прийнятним[21]

Оригінальний текст (англ.) A useful fact is that any Bayes decision rule obtained by taking a proper prior over the whole parameter space must be admissible |

| Важливим напрямком дослідження у розвитку ідей прийнятності був напрямок звичайних процедур теорії вибірок, і було отримано багато цікавих результатів.[22]

Оригінальний текст (англ.) An important area of investigation in the development of admissibility ideas has been that of conventional sampling-theory procedures, and many interesting results have been obtained. |

Обирання моделі

Застосування

Комп'ютерні застосування

Баєсове висновування має застосування в штучному інтелекті та експертних системах. Методики баєсового висновування були фундаментальною частиною методик комп'ютеризованого розпізнавання образів з кінця 1950-х років. Також існує й постійно зростає зв'язок між баєсовими методами та методиками Монте Карло на основі симуляцій, оскільки складні моделі не можуть оброблюватися в замкненому вигляді баєсовим аналізом, тоді як структури графових моделей можуть уможливлювати ефективні симуляційні алгоритми, такі як вибірка за Ґіббсом та інші схеми алгоритму Метрополіса — Гастінгса.[23] З цих причин баєсове висновування нещодавно завоювало популярність серед спільноти філогенетиків; деякі із застосувань дозволяють одночасно оцінювати багато демографічних та еволюційних параметрів.

Що стосується статистичної класифікації, то баєсове висновування застосовувалося у нещодавні роки для розробки алгоритмів ідентифікації спаму електронної пошти. До застосунків, що використовують баєсове висновування для фільтрування спаму, належать CRM114, DSPAM, Bogofilter, SpamAssassin, Mozilla, XEAMS та інші. Класифікація спаму розглядається докладніше у статті про наївний баєсів класифікатор.

Індуктивне висновування Соломонова є теорією передбачування, що ґрунтується на спостереженнях; наприклад, передбачення наступного символу ґрунтується на заданій серії символів. Єдиним припущенням є те, що середовище слідує якомусь невідомому, проте обчислюваному розподілу ймовірності. Це є формальна індуктивна структура, що поєднує в собі два гарно вивчені принципи індуктивного висновування: баєсову статистику та бритву Оккама.[24] Універсальна апріорна ймовірність Соломонова будь-якого префіксу p обчислюваної послідовності x — це сума ймовірностей усіх програм (для універсального комп'ютера), що обчислюють щось, що починається з p. При заданому деякому p та будь-якому обчислюваному але невідомому розподілі ймовірності, з якого вибирається x, для передбачування ще небачених частин x оптимальним чином можуть використовуватися універсальний апріорний розподіл та теорема Баєса.[25][26]

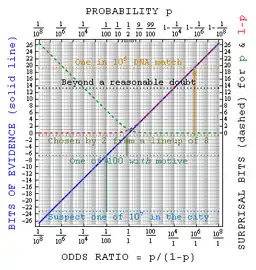

У залі суду

Баєсове висновування може застосовуватися присяжними, щоби послідовно накопичувати свідчення за та проти підсудного, і бачити, чи вони в сукупності відповідають їхньому особистому порогові «поза розумним сумнівом».[27][28][29] Теорема Баєса застосовується послідовно до усіх представлених свідчень так, що апостеріорне переконання з однієї стадії стає апріорним для наступної. Баєсів підхід корисний тим, що він надає присяжному неупереджений раціональний механізм для поєднання свідчень. Пояснювати теорему Баєса присяжним може бути доречно у формі шансів, оскільки шанси парі є зрозумілими ширшому загалові, аніж імовірності. Крім того, для присяжного може бути зрозумілішим логарифмічний підхід, що замінює множення додаванням.

Якщо в існуванні злочину сумніву немає, а є лише в особі обвинуваченого, то радять як апріорний використовувати рівномірний розподіл над визначеною сукупністю.[30] Наприклад, якщо 1 000 людей могли скоїти цей злочин, то апріорною ймовірністю провинності буде 1/1000.

Використання теореми Баєса присяжними є дискусійним. У Сполученому Королівстві судовий експерт захисту пояснив теорему Баєса суду присяжних у справі Р проти Адамса. Суд присяжних визнав відповідача винним, але на це рішення було подано апеляцію на тій підставі, що не було надано засобів акумулювання свідчень для тих присяжних, що не хотіли використовувати теорему Баєса. Апеляційний суд залишив вирок у силі, але також зробив висновок, що

| Залучення до кримінального процесу теореми Баєса, або іншого подібного методу, занурює присяжних у невідповідні та непотрібні сфери теорії та складності, відхиляючи їх від притаманної їм задачі"

Оригінальний текст (англ.) To introduce Bayes' Theorem, or any similar method, into a criminal trial plunges the jury into inappropriate and unnecessary realms of theory and complexity, deflecting them from their proper task. |

Гарднер-Медвін[31] переконує, що критерієм, на якому повинен базуватися вирок у кримінальній справі, є не ймовірність провини, а швидше ймовірність свідчення за умови невинності відповідача (близька до частотного p-значення). Він стверджує, що якщо апостеріорна ймовірність провини має обчислюватися за теоремою Баєса, то мусить бути відомою апріорна ймовірність провини. А вона залежатиме від сфери злочину, яка є незвичним свідченням для розгляду в кримінальній справі. Розгляньмо наступні три твердження:

- А Відомі факти та показання свідків могли би виникнути, якби відповідач був винним

- Б Відомі факти та показання свідків могли би виникнути, якби відповідач був невинним

- В Відповідач є винним.

Гарднер-Медвін стверджує, що для винесення обвинувального вироку суд присяжних повинен переконатися як в А, так і в не-Б. З А та не-Б випливає істинність В, але зворотнє не є вірним. Існує можливість, що вірними є Б та В, але в цьому випадку він стверджує, що суд присяжних повинен винести виправдувальний вирок, незважаючи на те, що вони знають, що дозволяють звільнитися деяким винним людям. Див. також парадокс Ліндлі.

Баєсова епістемологія

Баєсова епістемологія є рухом, що виступає за баєсове висновування як засіб обґрунтування правил індуктивної логіки.

Карл Поппер та Девід Міллер відкинули нібито раціональність баєсовизму, тобто використання правила Баєса для здійснення епістемологічного висновування:[32] він схильний до того ж порочного кола, що й будь-яка інша виправдовувальна епістемологія, оскільки спирається на те, що намагається виправдати. Відповідно до цієї точки зору, раціональна інтерпретація баєсового висновування бачитиме його лише як імовірнісну версію фальсифікаціонізму, заперечуючи переконання, поширене серед баєсовистів, що висока правдоподібність, досягнута послідовністю баєсових уточнень, доводитиме гіпотезу поза розумним сумнівом, чи навіть із правдоподібністю, більшою за 0.

Інші

- Науковий метод іноді інтерпретують як застосування баєсового висновування. З цієї точки зору правило Баєса скеровує (або повинне скеровувати) уточнення ймовірностей гіпотези в залежності від нових спостережень або експериментів.[33] Баєсове висновування також було застосовувано Цаєм та ін. (2009) до задач стохастичного планування з неповною інформацією.[34]

- Теорія баєсового пошуку застосовується для пошуку загублених об'єктів.

- Баєсове висновування у філогенетиці

- Баєсів інструмент для аналізу метилювання

- Баєсові підходи до функції мозку досліджують мозок як баєсів механізм.

- Баєсове висновування в екологічних дослідженнях[35][36]

- Баєсове висновування застосовують для оцінювання параметрів у стохастичних хімічних кінетичних моделях[37]

Баєс та баєсове висновування

Задачею, розглянутою Баєсом у Пропозиції 9 його «Есе щодо розв'язання задачі у Доктрині шансів», є апостеріорний розподіл параметру a (доля успішних спроб) біноміального розподілу.[38]

Історія

Детальніші відомості з цієї теми ви можете знайти в статті Історія статистики § Баєсова статистика.

Термін баєсів стосується Томаса Баєса (1702—1761), який довів окремий випадок того, що зараз називають теоремою Баєса. Однак, впровадив загальну версію цієї теореми та застосовував її для підходу до задач небесної механіки, медичної статистики, надійності та юриспруденції П'єр-Симон Лаплас (1749—1827).[39] Раннє баєсове висновування, що використовувало рівномірний апріорний розподіл згідно лапласового принципу недостатнього обґрунтування, називалося «зворотною ймовірністю» (оскільки воно здійснює зворотне висновування від спостережень до параметрів, або від наслідків до причин[40]). Після 1920-х років «зворотну ймовірність» було значною мірою витіснено набором методів, що стали називати частотною статистикою.[40]

У XX столітті ідеї Лапласа отримали подальший розвиток у двох різних напрямках, давши початок об'єктивній та суб'єктивній течіям у баєсовій практиці. В об'єктивній, або «неінформативній» течії статистичний аналіз покладається лише на передбачувану модель, аналізовані дані[41] та метод призначення апріорного розподілу, що відрізняється від одного об'єктивного баєсового висновування до іншого. У суб'єктивній, або «інформативній» течії визначення апріорного розподілу залежить від переконання (тобто тверджень, для дії на яких готується аналіз), що може підсумовувати інформацію від експертів, попередніх досліджень тощо.

У 1980-х роках відбувся різкий ріст досліджень та застосувань баєсових методів, обумовлений головним чином відкриттям методів Монте-Карло марковських ланцюгів, що усунули багато обчислювальних проблем, і ростом зацікавлення у нестандартних, складних застосуваннях.[42] Незважаючи на зростання баєсових досліджень, більшість викладання студентам і досі ґрунтується на частотній статистиці.[43] Тим не менше, баєсові методи є широко визнаними та застосовуваними, як наприклад у галузі машинного навчання.[44]

Див. також

- Теорема Баєса

- «Bayesian Analysis», журнал ISBA

- Баєсове ієрархічне моделювання

- Баєсова ймовірність

- Баєсова регресія

- Баєсів структурний часовий ряд (БСЧР, англ. BSTS)

- Індуктивна ймовірність

- Міжнародне співтовариство баєсового аналізу (англ. International Society for Bayesian Analysis, ISBA)

- Апріорний розподіл Джеффріса

- Парадокс Монті Голла

- Інформаційна теорія поля

Примітки

- Докінз, Річард (2018) [2006]. Ілюзія Бога. Переклад з англійської: Тарас Цимбал. Харків: КСД. с. 58. ISBN 978‑617‑12‑5700‑9.

- Кауфман, Джон (2018) [2010]. MBA в домашніх умовах: шпаргалки бізнес-практика. Переклад з англійської: Євгеній Кузнєцов (вид. 2). Київ: Наш Формат. ISBN 978-617-7552-53-5.

- Hacking (1967, Section 3, p. 316), Hacking (1988, p. 124) (англ.)

- Bayes' Theorem (Stanford Encyclopedia of Philosophy). Plato.stanford.edu. Процитовано 5 січня 2014. (англ.)

- van Fraassen, B. (1989) Laws and Symmetry, Oxford University Press. ISBN 0-19-824860-1 (англ.)

- Gelman, Andrew; Carlin, John B.; Stern, Hal S.; Dunson, David B.; Vehtari, Aki; Rubin, Donald B. (2013). Bayesian Data Analysis (вид. III). CRC Press. ISBN 978-1439840955. (англ.)

- Bond, Rachael L.; He, Yang-Hui; Ormerod, Thomas C. (2018). A quantum framework for likelihood ratios. International Journal of Quantum Information 16 (01): 1850002. Bibcode:2018IJQI…1650002B. ISSN 0219-7499. arXiv:1508.00936. doi:10.1142/s0219749918500028. (англ.)

- Freedman, DA (1963). On the asymptotic behavior of Bayes' estimates in the discrete case.. The Annals of Mathematical Statistics: 1386–1403. JSTOR 2238346. (англ.)

- Freedman, DA (1965). On the asymptotic behavior of Bayes estimates in the discrete case II. The Annals of Mathematical Statistics 36 (2): 454–456. JSTOR 2238150. (англ.)

- Larry Wasserman et alia, JASA 2000. (англ.)

- Sen, Pranab K.; Keating, J. P.; Mason, R. L. (1993). Pitman's measure of closeness: A comparison of statistical estimators. Philadelphia: SIAM. (англ.)

- Choudhuri, Nidhan; Ghosal, Subhashis; Roy, Anindya (1 січня 2005). Bayesian Methods for Function Estimation. Handbook of Statistics. Bayesian Thinking 25: 373–414. doi:10.1016/s0169-7161(05)25013-7. (англ.)

- Maximum A Posteriori (MAP) Estimation. www.probabilitycourse.com (англ.). Процитовано 2 червня 2017. (англ.)

- Yu, Angela. Introduction to Bayesian Decision Theory. cogsci.ucsd.edu/. Архів оригіналу за 28 лютого 2013. (англ.)

- Bickel & Doksum (2001, p. 32) (англ.)

- Kiefer, J.; Schwartz, R. (1965). Admissible Bayes Character of T2-, R2-, and Other Fully Invariant Tests for Multivariate Normal Problems. Annals of Mathematical Statistics 36: 747–770. doi:10.1214/aoms/1177700051. (англ.)

- Schwartz, R. (1969). Invariant Proper Bayes Tests for Exponential Families. Annals of Mathematical Statistics 40: 270–283. doi:10.1214/aoms/1177697822. (англ.)

- Hwang, J. T. & Casella, George (1982). Minimax Confidence Sets for the Mean of a Multivariate Normal Distribution. Annals of Statistics 10: 868–881. doi:10.1214/aos/1176345877. (англ.)

- Lehmann, Erich (1986). Testing Statistical Hypotheses (вид. Second). (див. с. 309 розділу 6.7 «Admissibilty» та с. 17–18 розділу 1.8 «Complete Classes» (англ.)

- Le Cam, Lucien (1986). Asymptotic Methods in Statistical Decision Theory. Springer-Verlag. ISBN 0-387-96307-3. (з розділу «12 Posterior Distributions and Bayes Solutions», с. 324) (англ.)

- Cox, D. R.; Hinkley, D.V (1974). Theoretical Statistics. Chapman and Hall. ISBN 0-04-121537-0. с. 432 (англ.)

- Cox, D. R.; Hinkley, D. V. (1974). Theoretical Statistics. Chapman and Hall. ISBN 0-04-121537-0. с. 433 (англ.)

- Jim Albert (2009). Bayesian Computation with R, Second edition. New York, Dordrecht, etc.: Springer. ISBN 978-0-387-92297-3. (англ.)

- Samuel Rathmanner та Marcus Hutter. «A Philosophical Treatise of Universal Induction». Entropy, 13(6):1076-1136, 2011. (англ.)

- «The Problem of Old Evidence», in § 5 of «On Universal Prediction and Bayesian Confirmation», M. Hutter — Theoretical Computer Science, 2007 — Elsevier (англ.)

- «Raymond J. Solomonoff», Peter Gacs, Paul M. B. Vitanyi, 2011 cs.bu.edu (англ.)

- Dawid, A. P. та Mortera, J. (1996) «Coherent Analysis of Forensic Identification Evidence». Journal of the Royal Statistical Society, Series B, 58, 425—443. (англ.)

- Foreman, L. A.; Smith, A. F. M., та Evett, I. W. (1997). «Bayesian analysis of deoxyribonucleic acid profiling data in forensic identification applications (with discussion)». Journal of the Royal Statistical Society, Series A, 160, 429—469. (англ.)

- Robertson, B. та Vignaux, G. A. (1995) Interpreting Evidence: Evaluating Forensic Science in the Courtroom. John Wiley and Sons. Chichester. ISBN ISBN 978-0-471-96026-3 (англ.)

- Dawid, A. P. (2001) «Bayes' Theorem and Weighing Evidence by Juries» Архівовано 1 липня 2015 у Wayback Machine. (англ.)

- Gardner-Medwin, A. (2005) «What Probability Should the Jury Address?». Significance, 2 (1), March 2005 (англ.)

- David Miller: Critical Rationalism (англ.)

- Howson & Urbach (2005), Jaynes (2003) (англ.)

- Cai, X.Q.; Wu, X.Y.; Zhou, X. (2009). Stochastic scheduling subject to breakdown-repeat breakdowns with incomplete information. Operations Research 57 (5): 1236–1249. (англ.)

- Ogle, Kiona; Tucker, Colin; Cable, Jessica M. (1 січня 2014). Beyond simple linear mixing models: process-based isotope partitioning of ecological processes. Ecological Applications (англ.) 24 (1): 181–195. ISSN 1939-5582. doi:10.1890/1051-0761-24.1.181. (англ.)

- Evaristo, Jaivime; McDonnell, Jeffrey J.; Scholl, Martha A.; Bruijnzeel, L. Adrian; Chun, Kwok P. (1 січня 2016). Insights into plant water uptake from xylem-water isotope measurements in two tropical catchments with contrasting moisture conditions. Hydrological Processes (англ.): n/a–n/a. Bibcode:2016HyPr...30.3210E. ISSN 1099-1085. doi:10.1002/hyp.10841. (англ.)

- Gupta, Ankur; Rawlings, James B. (2014-4). Comparison of Parameter Estimation Methods in Stochastic Chemical Kinetic Models: Examples in Systems Biology. AIChE Journal 60 (4): 1253–1268. ISSN 0001-1541. PMC 4946376. PMID 27429455. doi:10.1002/aic.14409. (англ.)

- Glenn Shafer and Pearl, Judea, eds. (1988) Probabilistic Reasoning in Intelligent Systems, San Mateo, CA: Morgan Kaufmann.

- Stigler, Stephen M. (1986). Chapter 3. The History of Statistics. Harvard University Press. (англ.)

- Fienberg, Stephen E. (2006). When did Bayesian Inference Become ‘Bayesian’?. Bayesian Analysis 1 (1): 1–40 [p. 5]. doi:10.1214/06-ba101. Архів оригіналу за 10 вересня 2014. (англ.)

- Bernardo, José-Miguel (2005). Reference analysis. Handbook of statistics 25. с. 17–90. (англ.)

-

Wolpert, R. L. (2004). A Conversation with James O. Berger. Statistical Science 19 (1): 205–218. MR 2082155. doi:10.1214/088342304000000053. Проігноровано невідомий параметр

|citeseerx=(довідка) (англ.) - Bernardo José M. (2006). A Bayesian mathematical statistics primer. ICOTS-7. (англ.)

- Bishop, C. M. (2007). Pattern Recognition and Machine Learning. New York: Springer. ISBN 0387310738. (англ.)

Джерела

- Aster, Richard; Borchers, Brian, та Thurber, Clifford (2012). Parameter Estimation and Inverse Problems, Second Edition, Elsevier. ISBN 0123850487, ISBN 978-0123850485 (англ.)

- Bickel, Peter J. & Doksum, Kjell A. (2001). Mathematical Statistics, Volume 1: Basic and Selected Topics (вид. Second (передрук 2007)). Pearson Prentice–Hall. ISBN 0-13-850363-X. (англ.)

- Box, G. E. P. та Tiao, G. C. (1973) Bayesian Inference in Statistical Analysis, Wiley, ISBN 0-471-57428-7 (англ.)

- Edwards, Ward (1968). Conservatism in Human Information Processing. У Kleinmuntz, B. Formal Representation of Human Judgment. Wiley. (англ.)

- Edwards, Ward (1982). Conservatism in Human Information Processing (excerpted). У Daniel Kahneman, Paul Slovic та Амос Тверські. Judgment under uncertainty: Heuristics and biases. Cambridge University Press. (англ.)

- Renganathan, Vinaitheerthan (31 березня 2016). Overview of Frequentist and Bayesian approach to Survival Analysis. Applied Medical Informatics (англ.) 38 (1): 25–38. ISSN 2067-7855. (англ.)

- Jaynes E. T. (2003) Probability Theory: The Logic of Science, CUP. ISBN 978-0-521-59271-0 (Link to Fragmentary Edition of March 1996). (англ.)

- Howson, C.; Urbach, P. (2005). Scientific Reasoning: the Bayesian Approach (вид. 3rd). Open Court Publishing Company. ISBN 978-0-8126-9578-6. Проігноровано невідомий параметр

|last-author-amp=(довідка) (англ.) - Phillips, L. D.; Edwards, Ward (October 2008). Chapter 6: Conservatism in a Simple Probability Inference Task (Journal of Experimental Psychology (1966) 72: 346-354). У Jie W. Weiss; David J. Weiss. A Science of Decision Making:The Legacy of Ward Edwards. Oxford University Press. с. 536. ISBN 978-0-19-532298-9. (англ.)

Література

- Повний звіт з історії баєсової статистики та дебати з частотними підходами читайте у Vallverdu, Jordi (2016). Bayesians Versus Frequentists A Philosophical Debate on Statistical Reasoning. New York: Springer. ISBN 978-3-662-48638-2. (англ.)

Початкова

Наступні книги перелічено у порядку зростання статистичної складності:

- Stone, JV (2013), «Bayes’ Rule: A Tutorial Introduction to Bayesian Analysis», Download first chapter here, Sebtel Press, England. (англ.)

- Dennis V. Lindley (2013). Understanding Uncertainty, Revised Edition (вид. 2nd). John Wiley. ISBN 978-1-118-65012-7. (англ.)

- Colin Howson; Peter Urbach (2005). Scientific Reasoning: The Bayesian Approach (вид. 3rd). Open Court Publishing Company. ISBN 978-0-8126-9578-6. (англ.)

- Berry, Donald A. (1996). Statistics: A Bayesian Perspective. Duxbury. ISBN 0-534-23476-3. (англ.)

- Morris H. DeGroot; Mark J. Schervish (2002). Probability and Statistics (вид. third). Addison-Wesley. ISBN 978-0-201-52488-8. Проігноровано невідомий параметр

|last-author-amp=(довідка) (англ.) - Bolstad, William M. (2007) Introduction to Bayesian Statistics: Second Edition, John Wiley ISBN 0-471-27020-2 (англ.)

- Winkler, Robert L (2003). Introduction to Bayesian Inference and Decision (вид. 2nd). Probabilistic. ISBN 0-9647938-4-9. (англ.) Оновлений класичний підручник. Чітко представлено баєсову теорію.

- Lee, Peter M. Bayesian Statistics: An Introduction. Fourth Edition (2012), John Wiley ISBN 978-1-1183-3257-3 (англ.)

- Carlin, Bradley P. & Louis, Thomas A. (2008). Bayesian Methods for Data Analysis, Third Edition. Boca Raton, FL: Chapman and Hall/CRC. ISBN 1-58488-697-8. (англ.)

- Gelman, Andrew; Carlin, John B.; Stern, Hal S.; Dunson, David B.; Vehtari, Aki; Rubin, Donald B. (2013). Bayesian Data Analysis, Third Edition. Chapman and Hall/CRC. ISBN 978-1-4398-4095-5. (англ.)

Середнього рівня або просунута

- Berger, James O (1985). Statistical Decision Theory and Bayesian Analysis. Springer Series in Statistics (вид. Second). Springer-Verlag. ISBN 0-387-96098-8. (англ.)

- Bernardo, José M.; Smith, Adrian F. M. (1994). Bayesian Theory. Wiley. (англ.)

- DeGroot, Morris H., Optimal Statistical Decisions. Wiley Classics Library. 2004. (початково опублікована (1970) McGraw-Hill.) ISBN 0-471-68029-X. (англ.)

- Schervish, Mark J. (1995). Theory of statistics. Springer-Verlag. ISBN 0-387-94546-6. (англ.)

- Jaynes, E. T. (1998) Probability Theory: The Logic of Science. (англ.)

- O'Hagan, A. та Forster, J. (2003) Kendall's Advanced Theory of Statistics, Volume 2B: Bayesian Inference. Arnold, New York. ISBN 0-340-52922-9. (англ.)

- Robert, Christian P (2001). The Bayesian Choice – A Decision-Theoretic Motivation (вид. second). Springer. ISBN 0-387-94296-3. (англ.)

- Glenn Shafer та Pearl, Judea, eds. (1988) Probabilistic Reasoning in Intelligent Systems, San Mateo, CA: Morgan Kaufmann. (англ.)

- Pierre Bessière et al. (2013), «Bayesian Programming», CRC Press. ISBN 9781439880326 (англ.)

- Francisco J. Samaniego (2010), «A Comparison of the Bayesian and Frequentist Approaches to Estimation» Springer, New York, ISBN 978-1-4419-5940-9 (англ.)

Посилання

- Hazewinkel, Michiel, ред. (2001). Bayesian approach to statistical problems. Encyclopedia of Mathematics. Springer. ISBN 978-1-55608-010-4. (англ.)

- Bayesian Statistics зі Scholarpedia. (англ.)

- Введення до баєсової ймовірності від Лондонського університету королеви Марії (англ.)

- Mathematical Notes on Bayesian Statistics and Markov Chain Monte Carlo (англ.)

- Баєсова рекомендована бібліографія, категоризована та анотована Томом Ґриффітсом (англ.)

- A. Hajek та S. Hartmann: Bayesian Epistemology, у: J. Dancy et al. (eds.), A Companion to Epistemology. Oxford: Blackwell 2010, 93-106. (англ.)

- S. Hartmann та J. Sprenger: Bayesian Epistemology, у: S. Bernecker and D. Pritchard (eds.), Routledge Companion to Epistemology. London: Routledge 2010, 609—620. (англ.)

- Stanford Encyclopedia of Philosophy: «Inductive Logic» (англ.)

- Bayesian Confirmation Theory (англ.)

- What Is Bayesian Learning? (англ.)