Глибинна мережа переконань

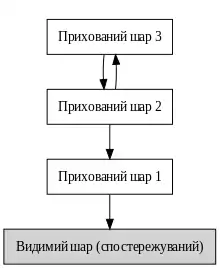

В машинному навчанні глиби́нна мере́жа перекона́нь (ГМП, англ. deep belief network, DBN) — це породжувальна графова модель, або, інакше, один із типів глибинних нейронних мереж, що складено з кількох шарів латентних змінних («прихованих вузлів»), зі з'єднаннями між шарами, але не між вузлами всередині кожного шару.[1]

При тренуванні на наборі прикладів спонтанним чином ГМП може навчатися ймовірнісно відбудовувати свої входи. Шари тоді виступають в ролі детекторів ознак на входах.[1] Після етапу навчання ГНМ може бути треновано далі керованим чином для здійснення класифікації.[2]

ГМП можна розглядати як композицію простих, спонтанних мереж, таких як обмежені машини Больцмана (ОМБ)[1] або автокодувальники,[3] в якій прихований шар кожної підмережі слугує видимим шаром для наступної. Це також веде до швидкої пошарової процедури спонтанного тренування, в якій порівняльна розбіжність застосовується до кожної підмережі по черзі, починаючи з «найнижчої» пари шарів (де найнижчим видимим шаром є тренувальний набір).

Спостереження, зроблене англ. Yee-Whye Teh, учнем Джефрі Хінтона,[2] про те, що ГМП може бути треновано жадібно шар за шаром, привело до одного з перших дієвих алгоритмів глибинного навчання.[4]

Алгоритм тренування

Алгоритм тренування ГМП працює наступним чином.[2] Нехай X буде матрицею входів, що розглядається як набір векторів ознак.

- Натренувати обмежену машину Больцмана на X, щоби отримати матрицю її вагових коефіцієнтів, W. Використовувати її як матрицю вагових коефіцієнтів між двома нижніми шарами мережі.

- Перетворити X за допомогою цієї ОМБ для отримання нових даних X', або шляхом вибірки, або обчисленням середньої активації прихованих вузлів.

- Повторювати цю процедуру з X ← X' для наступної пари шарів, поки не буде досягнуто двох верхніх шарів мережі.

- Здійснити тонке налаштування всіх параметрів цієї глибинної архітектури по відношенню до того, що виконує роль логарифмічної правдоподібності ГМП, або по відношенню до критерію керованого тренування (після додавання додаткових механізмів навчання для перетворення навченого представлення на керовані передбачення, наприклад, лінійного класифікатора).

Див. також

Примітки

- Hinton, G. (2009). Deep belief networks. Scholarpedia 4 (5): 5947. doi:10.4249/scholarpedia.5947. (англ.)

- Hinton, G. E.; Osindero, S.; Teh, Y. W. (2006). A Fast Learning Algorithm for Deep Belief Nets. Neural Computation 18 (7): 1527–1554. PMID 16764513. doi:10.1162/neco.2006.18.7.1527. (англ.)

- Yoshua Bengio; Pascal Lamblin; Dan Popovici; Hugh Larochelle (2007). Greedy Layer-Wise Training of Deep Networks NIPS. (англ.)

- Bengio, Y. (2009). Learning Deep Architectures for AI. Foundations and Trends in Machine Learning 2. doi:10.1561/2200000006. (англ.)

Посилання

- Глибинні мережі переконань. Підручники з глибинного навчання. (англ.)

- Приклад глибинної мережі переконань. Підручники Deeplearning4j. Архів оригіналу за 3 жовтня 2016. Процитовано 14 січня 2016. (англ.)