Глибинне навчання

Глиби́нне навча́ння (також відоме як глибинне структурне навчання, ієрархічне навчання, глибинне машинне навчання, англ. deep learning, deep structured learning, hierarchical learning, deep machine learning) — це галузь машинного навчання, що ґрунтується на наборі алгоритмів, які намагаються моделювати високорівневі абстракції в даних, застосовуючи глибинний граф із декількома обробними шарами, що побудовано з кількох лінійних або нелінійних перетворень.[1][2][3][4][5][6][7][8][9]

Глибинне навчання є частиною ширшого сімейства методів машинного навчання, що ґрунтуються на навчанні ознак даних. Спостереження (наприклад, зображення) може бути представлено багатьма способами, такими як вектор значень яскравості для пікселів, або абстрактнішим способом, як множина кромок, областей певної форми тощо. Деякі представлення є кращими за інші у спрощенні задачі навчання (наприклад, розпізнаванню облич, або виразів облич[10]). Однією з обіцянок глибинного навчання є заміна ознак ручної роботи дієвими алгоритмами автоматичного або напівавтоматичного навчання ознак та ієрархічного виділяння ознак.[11]

Дослідження в цій області намагаються зробити кращі представлення та створити моделі для навчання цих представлень з великомасштабних немічених даних. Деякі з цих представлень було зроблено під натхненням досягнень в нейронауці та з мотивів схем обробки та передавання інформації в нервовій системі, таких як нервове кодування, що намагається визначити зв'язок між різноманітними стимулами та пов'язаними нейронними реакціями в мозку.[12]

Різні архітектури глибинного навчання, такі як глибинні нейронні мережі, згорткові глибинні нейронні мережі, глибинні мережі переконань та рекурентні нейронні мережі застосовувалися в таких областях, як комп'ютерне бачення, автоматичне розпізнавання мовлення, обробка природної мови, розпізнавання звуків та біоінформатика, де вони, як було показано, представляють передові результати в різноманітних задачах.

Глибинне навчання характеризувалося як модне слово, або ребрендинг нейронних мереж.[13][14]

Введення

Визначення

Є кілька способів, якими характеризувалася галузь глибинного навчання. Наприклад, 1986 року Ріна Дехтер ввела поняття глибинного навчання першого порядку та глибинного навчання другого порядку в контексті задоволення обмежень.[15] Пізніше глибинне навчання було охарактеризовано як клас алгоритмів машинного навчання, які[2]

- використовують каскад багатьох шарів вузлів нелінійної обробки для виділяння ознак та перетворення. Кожен наступний шар використовує вихід із попереднього шару як вхід. Алгоритми можуть бути з керованим або спонтанним навчанням, а застосування включають розпізнавання образів (спонтанне) та класифікацію (керовану).

- ґрунтуються на навчанні (спонтанному) декількох шарів ознак або представлень даних. Ознаки вищих рівнів виводяться з ознак нижчих рівнів для формування ієрархічного представлення.

- є частиною ширшої області машинного навчання з навчання представлень даних.

- навчаються кільком рівням представлень, що відповідають різним рівням абстракції; ці рівні формують ієрархію понять.

Ці визначення мають спільними (1) декілька шарів вузлів нелінійної обробки та (2) кероване або спонтанне навчання представлень ознак у кожному з шарів, з формуванням шарами ієрархії від низькорівневих до високорівневих ознак.[2] Побудова шару вузлів нелінійної обробки, що застосовується в алгоритмі глибинного навчання, залежить від розв'язуваної задачі. Шари, що застосовувалися в глибинному навчанні, включають приховані шари штучної нейронної мережі та набори складних висловлень.[3] Вони також можуть включати латентні змінні, організовані по шарах у глибинних породжувальних моделях, такі як вузли в глибинних мережах переконань та глибинних машинах Больцмана.

Алгоритми глибинного навчання перетворюють свої входи крізь більшу кількість шарів, ніж алгоритми поверхневого навчання. На кожному шарі сигнал перетворюється блоком обробки, таким як штучний нейрон, параметри якого «навчаються» шляхом тренування.[5] Ланцюг перетворень від входу до виходу є шляхом передачі довіри (ШПД, англ. credit assignment path, CAP). ШПД описують потенційно причинні зв'язки між входом та виходом, і можуть мати змінну довжину. Для нейронної мережі прямого поширення довжина шляхів передачі довіри, і відтак глибина цієї мережі, є числом прихованих шарів плюс один (вихідний шар також параметризовано). Для рекурентних нейронних мереж, в яких сигнал може поширюватися через якийсь шар більше одного разу, ШПД має потенційно необмежену довжину. Універсально узгодженого порогу глибини, що відділяв би поверхневе навчання від глибинного, не існує, але більшість дослідників у цій галузі погоджуються, що глибинне навчання має декілька нелінійних шарів (ШПД > 2), а Шмідгубер розглядає ШПД > 10 як дуже глибинне навчання.[5]

Фундаментальні поняття

Алгоритми глибинного навчання ґрунтуються на розподілених представленнях. Припущенням, що лежить в основі розподілених представлень, є те, що спостережувані дані породжено взаємодією факторів, організованих у рівні. Глибинне навчання додає припущення, що ці рівні факторів відповідають різним рівням абстракції або побудови. Для забезпечення різних ступенів абстракції можуть застосовуватися змінні кількості та розміри шарів.[4]

Глибинне навчання використовує цю ідею ієрархічних пояснювальних факторів, де з понять нижчого рівня відбувається навчання абстрактніших понять вищого рівня. Ці архітектури часто будуються за допомогою пошарового жадібного методу. Глибинне навчання дозволяє розплутувати ці абстракції й вихоплювати ознаки, що є корисними для навчання.[4]

Для задач керованого навчання методи глибинного навчання уникають конструювання ознак, перетворюючи дані у компактні проміжні представлення на кшталт головних компонент, і виводять шаруваті структури, що усувають надмірність у представленні.[2]

Багато алгоритмів глибинного навчання застосовуються до задач спонтанного навчання. Це є важливою перевагою, оскільки немічені дані зазвичай є багатшими за мічені. Прикладами глибинних структур, які можуть тренуватися спонтанним чином, є нейронні стискачі історії[16] та глибинні мережі переконань.[17][4]

Інтерпретації

Глибинні нейронні мережі зазвичай інтерпретують у термінах теореми про універсальне наближення[18][19][20][21][22] або ймовірнісного висновування.[2][3][4][5][17][23]

Інтерпретація теореми про універсальне наближення

Теорема про універсальне наближення стосується здатності нейронних мереж прямого поширення з єдиним прихованим шаром наближувати неперервні функції.[18][19][20][21][22]

Її перше доведення було опубліковано 1989 року Джорджем Цибенком для сигмоїдних активаційних функцій,[19] і було узагальнено для багатошарових архітектур прямого поширення 1991 року Куртом Горником.[20]

Імовірнісна інтерпретація

Ймовірнісна інтерпретація[23] походить з галузі машинного навчання. Вона відводить провідне місце висновуванню,[2][3][4][5][17][23] а також таким поняттям оптимізації, як тренування та тестування, пов'язаним із узгодженням та узагальненням відповідно. Конкретніше, ймовірнісна інтерпретація розглядає нелінійність активації як кумулятивну функцію густини.[23] Див. глибинну мережу переконань. Імовірнісна інтерпретація привела до запровадження виключення (англ. dropout) як регуляризатора в нейронних мережах.[24]

Імовірнісну інтерпретацію було введено та популяризовано Джефрі Хінтоном, Джошуа Бенджо, Яном ЛеКуном та Юргеном Шмідгубером.

Історія

Перший загальний робочий алгоритм керованого навчання багаторівневоі мережі персептронів було опубліковано 1965 року Олексієм Івахненком та Валентином Лапою.[25] В праці 1971 року ними вже було описано нейронну мережу з 8 шарами, навченими методом групового урахування аргументів, який широко використовують і досі.[26][27] Ці ідеї було реалізовано в системі ідентифікації комп'ютера «Альфа», який продемонстрував сам процес навчання.[28][29] Інші архітектури глибинного навчання, зокрема побудовані зі штучних нейронних мереж (ШНМ), беруть свій початок щонайменше з неокогнітрону, запровадженого Куніхіко Фукусімою 1980 року.[30] ШНМ самі по собі беруть свій початок ще раніше. Виклик полягав у тому, як тренувати мережі з декількома шарами. 1989 року Яну ЛеКуну та ін. вдалося застосувати до глибинної нейронної мережі стандартний алгоритм зворотного поширення, що був відомим як зворотний режим автоматичного диференціювання з 1970 року,[31][32][33] з метою розпізнавання рукописних поштових індексів на поштових відправленнях. Незважаючи на успіх застосування алгоритму, тривалість тренування мережі на цьому наборі даних складала близько 3 днів, роблячи його практично недоцільним для загального використання.[34] 1993 року нейронний стискач історії Юргена Шмідгубера, реалізований як стек рекурентних нейронних мереж (РНМ), розв'язав задачу «дуже глибокого навчання»,[5] яка вимагає понад 1 000 послідовних шарів в РНМ, розгорнутій у часі.[35] 1995 року Брендан Фрей показав, що можливо натренувати мережу, що складається з шести повнозв'язних шарів та кількох сотень прихованих вузлів, застосовуючи алгоритм неспання-сну, який було розроблено спільно з Пітером Даяном та Джефрі Хінтоном.[36] Тим не менше, тренування зайняло два дні.

В низьку швидкість роблять свій внесок багато факторів, одним з яких є проблема зникання градієнту, проаналізована 1991 року Зеппом Хохрайтером.[37][38]

В той час як до 1991 року такі мережі застосовувалися для розпізнавання відокремлених двовимірних рукописних цифр, розпізнавання тривимірних об'єктів здійснювалося зіставленням двовимірних зображень із розробленою вручну тривимірною моделлю. Цзюян Вен та ін. висунули припущення, що людський мозок не використовує монолітні тривимірні моделі об'єктів, і 1992 року вони опублікували кресцептрон (англ. Cresceptron),[39][40][41] метод виконання розпізнавання тривимірних об'єктів безпосередньо із загромаджених сцен. Кресцептрон є каскадом багатьох шарів, подібних до неокогнітрону. Але, на відміну від неокогнітрону, який вимагав ручного об'єднання ознак програмістом, кресцептрон повністю автоматично навчився відкритого ряду спонтанних ознак на кожному шарі, де кожна ознака представляється ядром згортки. На додачу, кресцептрон також відділяв кожен вивчений об'єкт із загромадженої сцени шляхом зворотного аналізу через мережу. Максимізаційну підвибірку (англ. max-pooling), що нині часто запозичується глибинними нейронними мережами (наприклад, перевірками ImageNet), було вперше застосовано в кресцептроні для зменшення роздільної здатності положення на коефіцієнт (2×2) до 1 через каскад для кращого узагальнення. Незважаючи на ці переваги, популярним вибором у 1990-х та 2000-х роках були простіші моделі, що використовують розроблені вручну ознаки, орієнтовані на конкретні задачі, такі як фільтр Ґабора та методи опорних векторів (англ. support vector machines, SVM), з причини тодішніх обчислюваних витрат ШНМ, та браку розуміння того, як мозок автономно зв'язує свої біологічні мережі.

В довгій історії розпізнавання мовлення протягом багатьох років досліджувалося як поверхневе, так і глибинне навчання (наприклад, рекурентні мережі) штучних нейронних мереж.[42][43][44] Але ці методи ніколи не перемагали неоднорідну внутрішньо-ручну технологію ґаусових сумішевих моделей/прихованих марковських моделей (ҐСМ-ПММ, англ. GMM-HMM), що ґрунтується на породжувальних моделях мовлення, натренованих розрізнювально.[45] Було методично проаналізовано ряд ключових труднощів, включно зі зменшенням градієнту[37] та слабкою структурою часової кореляції в нейронних передбачувальних моделях.[46][47] Додатковими утрудненнями в ті ранні дні були брак великих тренувальних даних та слабші обчислювальні потужності. Отже, більшість дослідників розпізнавання мовлення, які розуміли такі перешкоди, відійшли від нейронних мереж, щоби займатися породжувальним моделюванням. Винятком був SRI International в кінці 1990-х років. Фінансований агенціями АНБ та DARPA уряду США, SRI здійснював дослідження з глибинних нейронних мереж у розпізнаванні мовлення та мовника. Команда розпізнавання мовника під проводом Ларрі Гека (англ. Larry Heck) досягла першого значного успіху з глибинними нейронними мережами в обробці мовлення, який було продемонстровано 1998 року на Оцінці розпізнавання мовника NIST (National Institute of Standards and Technology), і пізніше опубліковано в журналі Speech Communication.[48] І хоча SRI досяг успіху з глибинними мережами в розпізнаванні мовника, вони були безуспішними в демонстрації подібного успіху в розпізнаванні мовлення. Хінтон та ін. і Ден та ін. зробили огляд цієї нещодавньої історії про те, як їхня співпраця між собою, а потім і з колегами з-поміж чотирьох груп (Університету Торонто, Microsoft, Google та IBM), запалила відродження глибинних нейронних мереж в розпізнаванні мовлення.[49][50][51][52]

Сьогодні, проте, багато аспектів розпізнавання мовлення було перебрано методом глибинного навчання, який називається довгою короткочасною пам'яттю (ДКЧП, англ. long short-term memory, LSTM), рекурентною нейронною мережею, опублікованою Зеппом Хохрайтером та Юргеном Шмідгубером 1997 року.[53] РНМ ДКЧП уникають проблеми зникання градієнту, і можуть навчатися задач «дуже глибокого навчання»,[5] які вимагають спогадів про події, які сталися тисячі дискретних кроків часу тому, що є важливим у мовлені. 2003 року ДКЧП почала ставати конкурентноспроможною у порівнянні з традиційними розпізнавачами мовлення в деяких задачах.[54] Пізніше її було поєднано з НЧК (англ. CTC)[55] у стеках РНМ ДКЧП.[56] 2015 року в розпізнаванні мовлення Google, як повідомляється, стався різкий 49-відсотковий стрибок продуктивності завдяки НЧК-тренованій ДКЧП, яка тепер доступна через Google Voice користувачам усіх смартфонів,[57] і стала зразково-показовим прикладом глибинного навчання.

Згідно дослідження,[8] вираз «глибинне навчання» (англ. Deep Learning) було введено до спільноти машинного навчання Ріною Дехтер 1986 року,[15] і пізніше до штучних нейронних мереж — Ігорем Айзенбергом з колегами 2000 року.[58] Графік Google Ngram показує, що застосування цього терміну набрало обертів (фактично, злетіло) з 2000 року.[59] 2006 року публікація Джефрі Хінтона та Руслана Салахутдінова привернула додаткову увагу, показавши, як багатошарову нейронну мережу прямого поширення може бути попередньо натреновано шар за шаром, з розглядом кожного шару в свою чергу як спонтанної обмеженої машини Больцмана, а потім здійснено її тонке налаштування із застосуванням керованого зворотного поширення.[60] 1992 року Шмідгубер вже реалізував дуже подібну ідею для загальнішого випадку спонтанних глибинних ієрархій рекурентних нейронних мереж, і також експериментально показав її переваги для прискорення керованого навчання.[16][27]

З моменту свого відродження, глибинне навчання стало частиною багатьох передових систем у різноманітних дисциплінах, зокрема таких як комп'ютерне бачення та автоматичне розпізнавання мовлення (АРМ, англ. automatic speech recognition, ASR). Результати на широко вживаних оцінкових наборах, таких як TIMIT (АРМ) та MNIST (класифікація зображень), як і на ряді великих словникових задач розпізнавання мовлення, постійно покращуються новими застосуваннями глибинного навчання.[49][61][62] Нещодавно було показано, що архітектури глибинного навчання у вигляді згорткових нейронних мереж були чи не найефективнішими;[63][64] проте вони ширше застосовуються в комп'ютерному баченні, ніж в АРМ, і сучасне великомасштабне розпізнавання мовлення зазвичай ґрунтується на НЧК[55] для ДКЧП.[53][57][65][66][67]

Реальний вплив глибинного навчання в промисловості, мабуть, почався на початку 2000-х років, коли ЗНМ, згідно Яна ЛеКуна,[68] вже обробили оцінювані від 10 % до 20 % всіх перевірок, написаних у США на початку 2000-х років. Промислові застосування великомасштабного розпізнавання мовлення почалися близько 2010 року. Наприкінці 2009 року Лі Ден запросив Джефа Хінтона було до праці з ним та колегами в Microsoft Research для застосування глибинного навчання до розпізнавання мовлення. Вони співорганізували 2009 року Семінар NIPS з глибинного навчання для розпізнавання мовлення. Цей семінар спонукали обмеження глибинних породжувальних моделей мовлення, та можливість того, що ера великих обчислень та великих даних виправдовує серйозну спробу глибинних нейронних мереж (ГНМ, англ. deep neural net, DNN). Вважалося, що попереднє тренування ГНМ із застосуванням породжувальних моделей глибинних мереж переконань (ГМП, англ. deep belief net, DBN) подолає головні труднощі нейронних мереж, з якими зіткнулися в 1990-х роках.[51] Проте на ранніх етапах цього дослідження в Microsoft Research було виявлено, що без попереднього тренування, але при застосуванні великих кількостей тренувальних даних, і особливо ГНМ, розроблених з відповідно великими, контекстно-залежними вихідними шарами, породжувалися різко нижчі рівні похибки, ніж у тоді-передових ҐСМ-ПММ, а також у більш просунутих системах розпізнавання мовлення на базі породжувальних моделей. Це відкриття було перевірено кількома іншими головними групами дослідження розпізнавання мовлення.[49][69] Далі було встановлено, що природа похибок розпізнавання, продукованих цими двома типами систем, має характерні відмінності,[50][70] що приносить технічне розуміння того, як інтегрувати глибинне навчання до наявних високоефективних систем декодування мовлення в реальному часі, розгорнутих усіма головними гравцями в галузі розпізнавання мовлення. Історію цього знаменного розвитку в глибинному навчанні було описано та проаналізовано в нещодавніх книгах та статтях.[2][71][72]

Досягнення в апаратному забезпеченні також були важливими у поновленні зацікавлення глибинним навчанням. Зокрема, потужні графічні процесори (англ. GPU) добре підходять для того роду перемелювання чисел, матрично/векторної математики, що залучає машинне навчання.[73][74] Було показано, що графічні процесори прискорюють тренувальні алгоритми на порядки, повертаючи тривалості виконання з тижнів назад до днів.[75][76]

Штучні нейронні мережі

Деякі з найуспішніших методів глибинного навчання включають штучні нейронні мережі. Штучні нейронні мережі було розроблено під натхненням біологічної моделі 1959 року, запропонованої нобелівськими лауреатами Девідом Гантером Г'юбелем та Торстеном Візелем, які виявили два типи клітин у первинній зоровій корі: прості та складні клітини. Багато штучних нейронних мереж можуть розглядатися як каскадні моделі[39][40][41][77] типів клітин, надихнутих цими біологічними спостереженнями.

Нейрокогнітрон Фукусіми представив згорткові нейронні мережі, частково треновані спонтанним навчанням із вказаними людьми ознаками в нейронній площині. Ян ЛеКун та ін. (1989) застосували до таких архітектур контрольоване зворотне поширення.[78] Вен та ін. (1992) опублікували згорткові нейронні мережі «кресцептрон»[39][40][41] для розпізнавання тривимірних об'єктів із зображень загромаджених сцен та виділення таких об'єктів із зображень.

Очевидною потребою для розпізнавання звичайних тривимірних об'єктів є інваріантність відносно найменшого зсуву та стійкість до деформації. Підвибірка (англ. max-pooling) виявилася першою, запропонованою кресцептроном,[39][40] для надання мережі стійкості до від-малих-до-великих деформацій ієрархічним чином із застосуванням згортки. Максимізаційна підвибірка сприяє, хоча і не гарантує інваріантності відносно зсуву на рівні пікселів.[41]

З появою алгоритму зворотного поширення на основі автоматичного диференціювання[31][33][79][80][81][82][83][84][85][86] багато дослідників намагалися тренувати керовані глибинні штучні нейронні мережі з нуля, спочатку з невеликим успіхом. Дипломна праця Зеппа Хохрайтера 1991 року[37][38] формально ідентифікувала причину цієї невдачі в проблемі зникання градієнту, що впливає на багатошарові мережі прямого поширення та на рекурентні нейронні мережі. Рекурентні мережі тренуються шляхом розгортання їх у дуже глибоку мережу прямого поширення, де новий шар створюється для кожного моменту часу вхідної послідовності, оброблюваної мережею. Оскільки похибки поширюються від шару до шару, з числом шарів вони скорочуються експоненційно, перешкоджаючи налаштуванню вагових коефіцієнтів нейронів, яке ґрунтується на цих похибках.

Для подолання цієї проблеми було запропоновано декілька методів. Одним є багаторівнева ієрархія мереж Юргена Шмідгубера (1992 р.), попередньо тренована порівнево спонтанним навчанням, і тонко-налагоджувана зворотним поширенням.[16] Тут кожен рівень вчиться стисненого представлення спостережень, що подається на наступний рівень.

Іншим методом є мережа довгої короткочасної пам'яті (ДКЧП, англ. long short-term memory, LSTM) Хохрайтера та Шмідгубера (1997 р.).[53] 2009 року глибинні багатовимірні мережі ДКЧП виграли три змагання ICDAR 2009 з розпізнавання неперервного рукописного тексту без жодного попереднього знання про три мови, яких необхідно було навчитися.[87][88]

Свен Бенке 2003 року покладався лише на знак градієнту (Rprop), коли тренував свою Нейронну піраміду абстракцій (англ. Neural Abstraction Pyramid)[89] для розв'язання задач на кшталт відбудови зображень та локалізації облич.

Інші методи також застосовують спонтанне попереднє тренування для структурування нейронної мережі, даючи їй спочатку навчитися загальних корисних детекторів ознак. Потім ця мережа тренується далі керованим зворотним поширенням для класифікації мічених даних. Глибинна модель Хінтона та ін. (2006) включає навчання розподілу високорівневого представлення із застосуванням послідовних шарів двійкових або дійснозначних латентних змінних. Для моделювання кожного нового шару ознак вищого рівня вона використовує обмежену машину Больцмана (Смоленський, 1986[90]). Кожен новий шар гарантує підвищення нижньої межі логарифмічної правдоподібності даних, покращуючи таким чином модель, за правильного тренування. Щойно було навчено достатньо багато шарів, глибинну архітектуру можна застосовувати як породжувальну модель, відтворюючи дані шляхом здійснення вибірки вниз по моделі («родовий прохід», англ. "ancestral pass"), починаючи з активації ознак найвищого рівня.[91] Хінтон повідомляє, що його моделі є ефективними для виділяння ознак зі структурованих даних високої розмірності.[92]

Команда Google Brain під проводом Ендрю Ина та Джефа Діна створила[коли?] нейронну мережу, що навчилася розпізнавати високорівневі поняття, такі як коти, з самого лише перегляду немічених зображень, взятих із відеозаписів YouTube.[93][94]

Інші методи покладаються на чисту оброблювальну потужність сучасних комп'ютерів, зокрема, на графічні процесори. 2010 року Ден Чирешан з колегами[75] в групі Юргена Шмідгубера в швейцарській лабораторії штучного інтелекту IDSIA показали, що, незважаючи на вищезгадану «проблему зникання градієнту», надзвичайна обчислювальна потужність графічних процесорів робить звичайне зворотне поширення придатним для глибинних нейронних мереж прямого поширення з багатьма шарами. Цей метод перевершив усі інші методики машинного навчання на старій відомій задачі розпізнавання рукописних цифр MNIST Яна ЛеКуна та його колег з Нью-Йоркського університету.

Приблизно в цей самий час, наприкінці 2009 року, нейронні мережі прямого поширення з глибинним навчанням вчинили набіги на розпізнавання мовлення, як відмічено Семінаром NIPS з глибинного навчання для розпізнавання мовлення. Інтенсивна спільна робота дослідників з Microsoft Research та Університету Торонто продемонструвала в середині 2010 року в Редмонді, що глибинні нейронні мережі, пов'язані з прихованою марковською моделлю з контекстно-залежними станами, що визначає вихідний шар нейронної мережі, можуть різко скоротити похибки у великих задачах словникового розпізнавання мовлення, таких як голосовий пошук. Близько року по тому в Microsoft Research Asia було показано масштабування такої ж моделі глибинної нейронної мережі до задачі телефонного комутатора. Навіть раніше, 2007 року, ДКЧП,[53] тренована за допомогою НЧК,[55] почала отримувати відмінні результати в деяких застосуваннях.[56] Цей метод тепер широко застосовується, наприклад, у значно поліпшеному розпізнаванні мовлення Google для користувачів усіх смартфонів.[57]

Станом на 2011 рік передовим у нейронних мережах глибинного навчання прямого поширення є чергування згорткових (англ. convolutional) та підвибіркових (англ. max-pooling) шарів,[95][96] увінчаних декількома повнозв'язними або розріджено зв'язаними шарами, за якими слідує завершальний шар класифікації. Тренування зазвичай здійснюється без жодного спонтанного попереднього тренування. З 2011 року реалізації цього підходу на основі графічних процесорів[95] виграли багато змагань з розпізнавання образів, включно зі Змаганням з розпізнавання дорожніх знаків (англ. Traffic Sign Recognition Competition) IJCNN 2011,[97] Змаганням з сегментації нейронних структур в стеку електронної мікроскопії (англ. Segmentation of neuronal structures in EM stacks challenge) ISBI 2012,[98] Змаганням ImageNet[99] та іншими.

Такі керовані методи глибинного навчання також стали першими штучними розпізнавачами образів, що досягли в деяких задачах ефективності, порівняної з людською.[100]

Щоби подолати бар'єри слабкого штучного інтелекту, представленого глибинним навчанням, необхідно вийти за межі архітектур глибинного навчання, оскільки згідно інформації з анатомії мозку[101] біологічні мізки використовують як поверхневі так і глибинні ланцюги, демонструючи широке розмаїття інваріантності. Вен[102] стверджував, що мозок широко самоз'єднується відповідно до статистики сигналів, і отже, послідовний каскад не може вловити всі основні статистичні залежності. ШНМ виявилися здатними гарантувати інваріантність відносно зсуву, щоби мати справу з малими та великими природними об'єктами у великих загромаджених сценах, лише коли інваріантність поширилася за межі зсуву, на всі вивчені ШНМ поняття, такі як положення, тип (мітка класу об'єкту), масштаб, освітленість. Це було реалізовано в Еволюційних Мережах (ЕМ, англ. Developmental Networks, DN),[103] чиїми втіленнями є мережі де-що (англ. Where-What Networks), від WWN-1 (2008)[104] до WWN-7 (2013).[105]

Архітектури глибинних нейронних мереж

Існує величезна кількість варіантів глибинних архітектур. Більшість із них відгалужуються від деяких вихідних батьківських архітектур. Одночасне порівняння ефективності різних архітектур не завжди можливе, оскільки не всі з них оцінювалися на однакових наборах даних. Глибинне навчання є галуззю, що швидко розвивається, і нові архітектури, варіанти або алгоритми з'являються кожні кілька тижнів.

Стисле обговорення глибинних нейронних мереж

Глибинна нейронна мережа (ГНМ, англ. deep neural network, DNN) — це штучна нейронна мережа (ШНМ) з декількома прихованими шарами вузлів між вхідним та вихідним шарами.[3][5] Подібно до пласких ШНМ, ГНМ можуть моделювати складні нелінійні відношення. Архітектури ГНМ, наприклад, для виявлення об'єктів та граматичного аналізу, породжують композиційні моделі, де об'єкт виражається як шарувата композиція примітивів зображення.[106] Додаткові шари дозволяють композиції включати ознаки з нижчих шарів, забезпечуючи потенціал для моделювання складних даних меншою кількістю вузлів, ніж настільки ж ефективна пласка мережа.[3]

ГНМ зазвичай проектуються як мережі прямого поширення, але дослідження дуже успішно застосували рекурентні нейронні мережі, особливо ДКЧП,[53][107] до таких задач, як моделювання мов.[108][109][110][111][112] Згорткові глибинні нейронні мережі (ЗНМ, англ. convolutional deep neural networks, CNN) застосовуються в комп'ютерному зорі, де їхній успіх є добре задокументованим.[113] ЗНМ також було застосовано до акустичного моделювання для автоматичного розпізнавання мовлення (АРМ, англ. automatic speech recognition, ASR), де вони продемонстрували переваги над попередніми моделями.[64] Для спрощення, тут наведено погляд на тренування ГНМ.

Зворотне поширення

ГНМ може бути натреновано розрізнювально за допомогою стандартного алгоритму зворотного поширення. Згідно різних джерел,[5][8][86][114] основи безперервного зворотного поширення було виведено в контексті теорії керування Генрі Келлі[81] 1960 року та Артуром Брайсоном 1961 року,[82] із застосуванням принципів динамічного програмування. 1962 року Стюарт Дрейфус опублікував простіше виведення на основі лише ланцюгового правила.[83] Володимир Вапник цитує посилання [115] у своїй книзі про Метод опорних векторів. Артур Брайсон та Ю Ці Хо описали це як багатоетапний метод оптимізації динамічної системи 1969 року.[116][117] 1970 року Сеппо Ліннаінмаа остаточно опублікував загальний метод автоматичного диференціювання (АД, англ. AD) дискретних зв'язних мереж вкладених диференційовних функцій.[31][118] Це відповідає сучасній версії зворотного поширення, яка є дієвою навіть коли мережі є розрідженими.[5][8][32][80] 1973 року Стюарт Дрейфус застосував зворотне поширення для адаптування параметрів регуляторів у пропорції до градієнтів похибок.[84] 1974 року Пол Вербос зазначив можливість застосування цього принципу до штучних нейронних мереж,[119] а 1982 року він застосував метод АД Ліннаінмаа до нейронних мереж таким чином, яким він широко застосовується сьогодні.[8][79] 1986 року Девід Румельхарт, Джефрі Хінтон та Рональд Вільямс показали шляхом комп'ютерних експериментів, що цей метод може породжувати корисні внутрішні представлення вхідних даних у прихованих шарах нейронних мереж.[85] 1993 року Ерік Ван (англ. Eric A. Wan) став першим,[5] хто переміг у міжнародному змаганні з розпізнавання образів із зворотним поширенням.[120]

Уточнення вагових коефіцієнтів може здійснюватися стохастичним найшвидшим спуском із застосуванням наступного рівняння:

Тут є темпом навчання, а — функцією витрат. Вибір функції витрат залежить від таких факторів, як тип навчання (кероване, спонтанне, з підкріпленням тощо) та функції активації. Наприклад, при виконанні керованого навчання для задачі багатокласової класифікації звичайним вибором для функції активації та функції витрат є нормована експоненційна функція (англ. softmax) та функція перехресної ентропії відповідно. Багатозмінна логістична функція визначається як , де представляє ймовірність класу (вихід вузла ), а та представляють сумарний вхід до вузлів та на одному й тому ж рівні відповідно. Перехресна ентропія визначається як , де представляє цільову ймовірність для вихідного вузла , а є виходом ймовірності для після застосування активаційної функції.[121]

Вони можуть використовуватися для виведення описаних прямокутників об'єктів у вигляді двійкової маски. Вони також використовуються для багатомасштабної регресії для підвищення точності визначення положення. Регресія на базі ГНМ може навчатися ознак, що схоплюють геометричну інформацію, на додачу до того, що вони є добрим класифікатором. Вони усувають обмеження розробки моделі, що фіксуватиме деталі та їхні зв'язки явно. Це дозволяє навчатися широкого спектра об'єктів. Модель складається з кількох шарів, кожен з яких має ReLU для нелінійного перетворення. Деякі шари є згортковими, тоді як деякі є повноз'єднаними. Кожен згортковий рівень має додаткову підвибірку (англ. max pooling). Мережа тренується мінімізувати похибки L2 для передбачення маски на діапазоні всього тренувального набору, що містить описані прямокутники, представлені як маски.

Проблеми з глибинними нейронними мережами

Як і з ШНМ, з ГНМ може виникати багато проблем, якщо вони тренуються наївно. Двома поширеними проблемами є перенавчання та тривалість обчислення.

ГНМ схильні до перенавчання через додані шари абстракції, що дозволяють їм моделювати рідкісні залежності в тренувальних даних. Для допомоги в боротьбі з перенавчанням під час тренування можуть застосовуватися методи регуляризації, такі як відсікання вузлів Івахненка[26], зменшення вагових коефіцієнтів (-регуляризація) та розрідженість (-регуляризація).[122] Новішим методом регуляризації, що застосовується до ГНМ, є регуляризація виключенням (англ. dropout). При виключенні під час тренування деяка кількість вузлів з прихованих шарів випадково пропускається. Це допомагає зламати рідкісні залежності, що можуть траплятися в тренувальних даних.[123]

Панівним методом для тренування цих структур було тренування з коригуванням похибок (таке як зворотне поширення з градієнтним спуском), завдяки простоті його реалізації та його схильності до кращих локальних оптимумів, ніж інші методи тренування. Проте ці методи можуть бути обчислювально витратними, особливо для ГНМ. Є багато параметрів, які потрібно розглядати при ГНМ, такі як розмір (кількість шарів та кількість вузлів на шар), темп навчання та початкові вагові коефіцієнти. Прочісування простору параметрів у пошуку оптимальних може не бути придатним з причини витрат часу та обчислювальних ресурсів. Було показано, що різні «хитрощі», такі як міні-групування (англ. mini-batching, обчислення градієнту на кількох тренувальних прикладах одночасно, а не на окремих прикладах),[124] можуть пришвидшувати обчислення. Велика обробна пропускна спроможність графічних процесорів спричинила значне прискорення тренувань, оскільки потрібні матричні та векторні обчислення добре підходять для графічних процесорів.[5] Увагу привернули докорінні альтернативи зворотному поширенню, такі як машини екстремального навчання (англ. Extreme Learning Machines, ELM),[125] «безпоширні» (англ. «No-prop») мережі,[126] тренування без пошуку з вертанням[127] та «безвагові» нейронні мережі (англ. Weightless neural networks, WNN)[128] та не-зв'язницькі нейронні мережі (англ. non-connectionist neural networks).

Перші мережі глибинного навчання 1965 року: МГУА

Згідно історичного дослідження,[5] перші працездатні мережі глибинного навчання з багатьма шарами було опубліковано Олексієм Григоровичем Івахненком та Валентином Григоровичем Лапою 1965 року.[25][129] Цей алгоритм навчання було названо методом групового урахування аргументів, або МГУА (англ. Group Method of Data Handling, GMDH).[130] МГУА пропонує повністю повністю автоматичну структурну та параметричну оптимізацію моделей. Функції активації вузлів мережі є поліномами Колмогорова — Габора, які дозволяють додавання та множення. Праця Івахненка 1971 року[26] описує навчання глибинного багатошарового перцептрону прямого поширення з вісьмома шарами, вже набагато глибшого за багато пізніших мереж. Мережа керованого навчання нарощується шар за шаром, кожен шар тренується регресійним аналізом. Час від часу непотрібні нейрони виявляються за допомогою набору перевірок, і відсікаються через регуляризацію. Розмір та глибина отримуваної в результаті мережі залежать від задачі. Варіації цього методу застосовуються й досі.[131]

Згорткові нейронні мережі

ЗНМ стали методом, який вибирають для обробки візуальних та інших двовимірних даних.[34][68] ЗНМ складається з одного або більше згорткових шарів із повноз'єднаними шарами (що відповідають таким у типовій штучній нейронній мережі) нагорі. Вона також застосовує зв'язані вагові коефіцієнти та агрегувальні шари. Зокрема, у згортковій архітектурі Фукусіми часто застосовується максимізаційна підвибірка.[40][30] Ця архітектура дозволяє ЗНМ отримувати переваги від двовимірної структури вхідних даних. У порівнянні з іншими глибинними архітектурами, згорткові нейронні мережі показали чудові результати в застосуваннях як до зображень, так і до мовлення. Їх також може бути треновано стандартним зворотним поширенням. ЗНМ є простішими для тренування від інших звичайних, глибинних, нейронних мереж прямого поширення, і мають набагато менше параметрів для оцінки, що робить їх дуже привабливою архітектурою для застосування.[132] Приклади застосування в комп'ютерному баченні включають DeepDream.[133] Численні додаткові посилання див. у статті про згорткові нейронні мережі.

Нейронний стискач історії

Проблему зникання градієнту[37] автоматичного диференціювання та зворотного поширення в нейронних мережах було частково подолано 1992 року ранішою породжувальною моделлю, яка називається нейронним стискачем історії, реалізованою як некерований стек рекурентних нейронних мереж (РНМ).[16] РНМ на вхідному рівні навчається передбаченню свого наступного входу з історії попередніх входів. Лише непередбачувані входи деяких РНМ в ієрархії стають входами до наступних РНМ вищого рівня, які відтак переобчислюють свій внутрішній стан лише зрідка. Кожна РНМ вищого рівня таким чином навчається стисненого представлення інформації в нижчій РНМ. Це робиться таким чином, що вхідну послідовність може бути точно відбудовано з представлення послідовності на найвищому рівні. Система дієво мінімізує довжину опису, або від'ємний логарифм імовірності даних.[8] Якщо в послідовності вхідних даних є багато навчаної передбачуваності, то РНМ найвищого рівня може використовувати кероване навчання, щоби легко класифікувати навіть глибокі послідовності з дуже тривалими проміжками часу між важливими подіями. 1993 року така система вже розв'язала задачу «дуже глибокого навчання», яка вимагає понад 1 000 послідовних шарів в РНМ, розгорнутій у часі.[35]

Також є можливим переганяти всю ієрархію РНМ в лише дві РНМ, які називають «свідомим» фрагментувальником (вищий рівень) та «підсвідомим» автоматизатором (нижчий рівень).[16] Щойно фрагментувальник навчився передбачувати та стискати входи, що є все ще непередбачуваними для автоматизатора, як автоматизатор змушується на наступній фазі навчання передбачувати або імітувати через особливі додаткові вузли приховані вузли фрагментувальника, який змінюється повільніше. Це полегшує автоматизаторові навчання відповідних, рідко змінюваних спогадів протягом дуже тривалих проміжків часу. Це, в свою чергу, допомагає автоматизаторові робити багато з його раніше непередбачуваних входів передбачуваними, так що фрагментувальник може зосереджуватися на подіях, які все ще лишаються непередбачуваними, щоби стискати дані ще далі.[16]

Рекурсивні нейронні мережі

Рекурсивна нейронна мережа (англ. recursive neural network)[134] створюється шляхом рекурсивного застосування одного й того ж набору вагових коефіцієнтів над диференційовною графоподібною структурою, шляхом обходу цієї структури в топологічному порядку. Такі мережі зазвичай також тренуються оберненим режимом автоматичного диференціювання.[31][80] Їх було запропоновано для навчання розподілених представлень структури, таких як логічні терми. Окремим випадком рекурсивних нейронних мереж є власне РНМ, чия структура відповідає лінійному ланцюгові. Рекурсивні нейронні мережі застосовувалися до обробки природної мови.[135] Рекурсивна нейронна тензорна мережа (англ. Recursive Neural Tensor Network) використовує для всіх вузлів у дереві композиційну функцію на основі тензора.[136]

Довга короткочасна пам'ять

Численні дослідники нині застосовують варіанти РНМ глибинного навчання, яка називається мережею довгої короткочасної пам'яті (ДКЧП, англ. Long short-term memory, LSTM), опублікованої Хохрайтером та Шмідгубером 1997 року.[53] Вона є системою, яка, на відміну від традиційних РНМ, не має проблеми зникання градієнту. ДКЧП зазвичай доповнюються рекурентними вентилями, які називаються забувальними (англ. forget gates).[107] РНМ ДКЧП попереджають зворотнє поширення похибок від зникання градієнту або вибуху значень вагових коефіцієнтів.[37] Замість цього похибки можуть текти назад крізь необмежені кількості віртуальних шарів розгорнутих у просторі РНМ ДКЧП. Тобто, ДКЧП може навчатися завдань «дуже глибокого навчання»,[5] які вимагають спогадів про події, що сталися тисячі або навіть мільйони дискретних кроків часу тому. Може бути розвинено проблемно-орієнтовані ДКЧП-подібні топології.[137] ДКЧП працює навіть за наявності дуже тривалих затримок, і може обробляти сигнали, які містять суміш низько- та високочастотних складових.

Сьогодні багато застосувань використовують стеки РНМ ДКЧП,[138] і тренують їх нейромережевою часовою класифікацією (НЧК, англ. Connectionist Temporal Classification, CTC)[55] для знаходження вагової матриці РНМ, яка максимізує ймовірність послідовностей міток у тренувальному наборі для заданих відповідних вхідних послідовностей. НЧК досягає як вирівнювання, так і розпізнавання. 2009 року ДКЧП, тренована НЧК, стала першою РНМ, яка перемогла в змаганнях із розпізнавання образів, коли вона виграла кілька змагань із неперервного рукописного розпізнавання.[5][87] Вже 2003 року ДКЧП почала ставати конкурентноспроможною у порівнянні з традиційними розпізнавачами мовлення в деяких задачах.[54] 2007 року поєднання з НЧК отримало перші добрі результати на даних мовлення.[56] Відтоді цей підхід революціював розпізнавання мовлення. 2014 року китайський пошуковий гігант Baidu застосував РНМ, треновані НЧК, щоби перевершити еталон розпізнавання мовлення Switchboard Hub5'00, без застосування будь-яких традиційних методів обробки мовлення.[139] ДКЧП також поліпшила велико-словникове розпізнавання мовлення,[65][66] синтез мовлення з тексту,[140] також і для Google Android,[8][67] і фото-реалістичні голови, що розмовляють.[141] 2015 року в розпізнаванні мовлення Google, як повідомляється, стався різкий 49-відсотковий стрибок продуктивності завдяки НЧК-тренованій ДКЧП, яка тепер доступна через Google Voice мільярдам користувачам смартфонів.[57]

ДКЧП також стала дуже популярною в галузі обробки природної мови. На відміну від попередніх моделей на основі ПММ та подібних понять, ДКЧП може вчитися розпізнавати контекстно-чутливі мови.[108] ДКЧП поліпшила машинний переклад,[109] моделювання мов[110] та багатомовну обробку мов.[111] ДКЧП у поєднанні зі згортковими нейронними мережами (ЗНМ) також поліпшила автоматичний опис зображень[142] і безліч інших застосувань.

Глибинні мережі переконань

Глибинна мережа переконань (ГМП, англ. deep belief network, DBN) є ймовірнісною породжувальною моделлю, зробленою з кількох шарів прихованих вузлів. Її можна розглядати як композицію простіших модулів навчання, що утворюють кожен із шарів.[17]

ГМП можуть застосовуватися для породжувального попереднього тренування ГНМ шляхом застосування навчених вагових коефіцієнтів ГМП як початкових вагових коефіцієнтів ГНМ. Для точного налаштування цих вагових коефіцієнтів можуть застосовуватися зворотне поширення або інші розрізнювальні алгоритми. Це особливо корисно тоді, коли доступні тренувальні дані є обмеженими, оскільки вагові коефіцієнти з погано заданими початковими значеннями можуть значно заважати ефективності навченої моделі. Ці попередньо натреновані вагові коефіцієнти знаходяться в області простору вагових коефіцієнтів, що є ближчою до оптимальних вагових коефіцієнтів, ніж випадково вибрані початкові значення. Це передбачає як поліпшення моделювання, так і швидшу збіжність фази тонкого налаштування.[143]

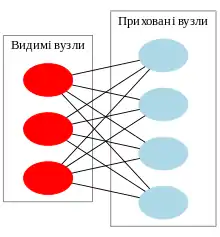

ГМП можуть ефективно тренуватися спонтанним пошаровим чином, де кожен шар, як правило, зроблено з обмеженої машини Больцмана (ОМБ, англ. restricted Boltzmann machine, RBM). ОМБ є неорієнтованою породжувальною моделлю на основі енергії, з «видимим» вхідним шаром та прихованим шаром, і з'єднаннями між шарами, але не в межах шарів. Метод тренування ОМБ, запропонований Джефрі Хінтоном для застосування при тренуванні моделей «добутку експертів» (англ. "Product of Expert" models), називається порівняльною розбіжністю (ПР, англ. contrastive divergence, CD).[144] ПР забезпечує наближення методу максимальної правдоподібності, який було би ідеально застосовувати при навчанні вагових коефіцієнтів ОМБ.[124][145] При навчанні однієї ОМБ уточнення вагових коефіцієнтів виконуються градієнтним підйомом за наступним рівнянням:

- .

Тут є ймовірністю видимого вектора, що задається як . є статистичною сумою (що застосовується для нормалізації), а є функцією енергії, призначеної станові мережі. Нижча енергія показує, що мережа знаходиться в „бажанішій“ конфігурації. Градієнт має простий вигляд , де представляє середні значення по відношенню до розподілу . Проблема виникає у вибірці , оскільки це вимагає виконання поперемінних вибірок за Ґіббсом протягом тривалого часу. ПР замінює цей крок виконанням поперемінних вибірок Ґіббса для кроків (було емпірично показано, що значення працює добре). Після кроків робиться вибірка з даних, і ця вибірка застосовується замість . Процедура ПР працює наступним чином:[124]

- Встановити видимим вузлам значення тренувального вектора.

- Паралельно уточнити приховані вузли для даних видимих вузлів: . є сигмоїдною функцією, а є зсувом .

- Паралельно уточнити видимі вузли для даних прихованих вузлів: . є зсувом . Це називається кроком „відбудови“.

- Повторно паралельно уточнити приховані вузли для даних відбудованих видимих вузлів із застосуванням такого ж рівняння, як у кроці 2.

- Виконати уточнення вагових коефіцієнтів: .

Щойно ОМБ натреновано, поверх неї „накладається“ інша ОМБ, беручи свої входи із завершального вже натренованого рівня. Значенням нового вхідного видимого шару встановлюється тренувальний вектор, а значення вузлів уже натренованих шарів встановлюються із застосуванням поточних вагових коефіцієнтів та зсувів. Потім нова ОМБ тренується за наведеною вище процедурою. Весь цей процес повторюється до досягнення бажаного критерію зупинки.[3]

Хоча наближення ПР до максимальної правдоподібності і є дуже грубим (було показано, що ПР не слідує градієнтові будь-якої функції), було емпірично показано, що вона є ефективною в тренуванні глибинних архітектур.[124]

Згорткові глибинні мережі переконань

Нещодавнім досягненням у глибинному навчанні є застосування згорткових глибинних мереж переконань (ЗГМП, англ. convolutional deep belief networks, CDBN). ЗГМП мають структуру, дуже подібну до згорткових нейронних мереж, і тренуються подібно до глибинних мереж переконань. Таким чином, вони використовують двовимірну структуру зображень, як це роблять ЗНМ, і використовують попереднє тренування, як глибинні мережі переконань. Вони пропонують загальну структуру, що може застосовуватися в багатьох задачах обробки зображень та сигналів. Останнім часом багато еталонних результатів на стандартних наборах зображень, таких як CIFAR,[146] було отримано із застосуванням ЗГМП.[147]

Нейронні мережі зберігання та вибірки великої пам'яті

Нейронні мережі зберігання та вибірки великої пам'яті (англ. large memory storage and retrieval, LAMSTAR)[148][149] є швидкими нейронними мережами глибинного навчання з багатьма шарами, які можуть використовувати багато фільтрів одночасно. Ці фільтри можуть бути нелінійними, стохастичними, логічними, не стаціонарними та навіть не аналітичними. Вони є біологічно натхненними, і мають неперервне навчання.

Нейронна мережа LAMSTAR може слугувати динамічною нейронною мережею в просторовій, часовій області визначення, та в обох. Її швидкість забезпечується геббовими ваговими коефіцієнтами з'єднань,[150] що слугують об'єднанню різних і, як правило, несхожих фільтрів (функцій попередньої обробки) у її численні шари, і для динамічного ранжування значимості різних шарів та функцій по відношенню до заданої задачі для глибинного навчання. Це грубо імітує біологічне навчання, що об'єднує виходи різних препроцесорів (зави́тки, сітківки тощо), кори (слухової, зорової тощо) та різних її областей. Її здатність до глибинного навчання додатково підсилюється використанням пригнічування, кореляції та її здатністю впоруватися з неповними даними, або „втраченими“ нейронами чи шарами навіть посеред завдання. Крім того, вона є повністю прозорою завдяки своїм ваговим коефіцієнтам з'єднань. Ці ваги з'єднань також уможливлюють нововведення, надмірність, і слугують ранжуванню по відношенню до завдання шарів, фільтрів та окремих нейронів.

LAMSTAR застосовували в багатьох медичних[151][152][153] та фінансових прогнозах,[154] адаптивному фільтруванні зашумленого мовлення в невідомому шумі,[155] розпізнаванні нерухомих зображень,[156][157] відео,[158] безпеці програмного забезпечення,[159] адаптивному керуванні нелінійними системами[160] та ін. У порівняльному дослідженні з розпізнавання символів LAMSTAR мала значно вищу швидкість обчислення і дещо нижчі похибки, ніж згорткова нейронна мережа на основі фільтрування функціями ReLU та максимізаційної підвибірки.[161]

Ці застосування показують занурення в аспекти даних, що є прихованими від мереж поверхневого навчання, та навіть від людських чуттів (ока, вуха), як у випадках передбачення настання подій апное уві сні,[152] електрокардіограми плоду при записі з електродів на поверхні шкіри живота матері в ранній період вагітності,[153] фінансового прогнозування[148] та сліпого фільтрування зашумленого мовлення.[155]

LAMSTAR було запропоновано 1996 року (A U.S. Patent 5 920 852 A), і розвинуто далі Даніелем Ґраупе (англ. Daniel Graupe) та Губертом Кордилевським (англ. Hubert Kordylewski) у 1997—2002 роках.[162][163][164] Видозмінену версію, відому як LAMSTAR 2, було розроблено Натаном Шнайдером (англ. Nathan C. Schneider) та Даніелем Ґраупе 2008 року.[165][166]

Глибинні машини Больцмана

Глибинна машина Больцмана (ГМБ, англ. Deep Boltzmann Machine, DBM) — це тип двійкового парного марковського випадкового поля (неорієнтованої імовірнісної графової моделі) з кількома шарами прихованих випадкових змінних. Вона є мережею симетрично спарованих випадкових двійкових вузлів. Вона складається з набору видимих вузлів та ряду шарів прихованих вузлів . З'єднань між вузлами одного й того ж рівня не існує (як і в ОМБ). Для ГМБ ймовірністю, що приписується векторові ν, є

де є наборами прихованих вузлів, а є параметрами моделі, що представляють взаємодії видимі-приховані та приховані-видимі. Якщо та , то ця мережа є добре відомою обмеженою машиною Больцмана.[167] Взаємодії є симетричними, оскільки зв'язки є неорієнтованими. На противагу, в глибинній мережі переконань (ГМП) лише верхні два шари утворюють обмежену машину Больцмана (що є неорієнтованою графовою моделлю), але нижчі шари утворюють орієнтовану породжувальну модель.

Як і ГМП, ГМБ можуть навчатися складних та абстрактних внутрішніх представлень входу в таких задачах, як розпізнавання об'єктів та мовлення, використовуючи обмежені мічені дані для тонкого налаштування представлення, побудованого з використанням великої поставки немічених вхідних сенсорних даних. Одначе, на відміну від ГМП та глибинних згорткових нейронних мереж, вони приймають на озброєння висновування та процедуру тренування в обох напрямках, на спадному та висхідному проходах, що дозволяє ГМБ краще розкривати представлення неоднозначних та складних вхідних структур.[168][169]

Проте швидкість ГМБ обмежує їхню продуктивність та функційність. Оскільки навчання точної максимальної правдоподібності є для ГМБ непіддатливим, ми можемо виконувати навчання наближеної максимальної правдоподібності. Іншим варіантом є застосовування висновування осередненого поля (англ. mean-field inference) для оцінки залежних від даних очікувань, і наближення очікуваної достатньої статистики моделі застосуванням методів Монте-Карло марковських ланцюгів (МКМЛ).[167] Це наближене висновування, що мусить бути здійснено для кожного перевірного входу, є у від 25 до 50 разів повільнішим за єдиний висхідний прохід у ГМП. Це робить спільну оптимізацію вельми непрактичною для великих наборів даних, і серйозно обмежує застосування ГМБ в таких задачах як представлення ознак.[170]

Складені (знешумлювальні) автокодувальники

Ідею автокодувальника продиктовано поняттям доброго представлення. Наприклад, для класифікатора добре представлення може бути визначено як таке, що дасть ефективніший класифікатор.

Кодувальник (англ. encoder) — це детерміністське відображення , що перетворює вхідний вектор x на приховане представлення y, де , є ваговою матрицею, а b є вектором зсуву. Декодувальник (англ. decoder) відображає назад приховане представлення y на відтворений вхід z через . Весь процес автокодування є порівнянням цього відтвореного входу з оригінальним, і намаганням мінімізувати цю похибку, щоби зробити відтворене значення якомога ближчим до оригінального.

В складених знешумлювальних автокодувальниках (англ. stacked denoising auto encoders) частково спотворений вихід очищується (знешумлюється, англ. denoised). Цю ідею було представлено 2010 року Венсаном та ін.[171] разом з особливим підходом до доброго представлення, добре представлення є таким, що може бути надійно отримано зі спотвореного входу, і буде корисним для відновлення відповідного чистого входу. Неявними в цьому визначенні є наступні ідеї:

- Представлення вищого рівня є відносно стабільними й стійкими до спотворень входу;

- Необхідно виділяти ознаки, що є корисними для представлення розподілу входу.

Алгоритм складається з кількох кроків: починається з імовірнісного відображення на через , це є спотворювальним кроком. Потім спотворений вхід проходить основним процесом автокодування, і відображується на приховане представлення . З цього прихованого представлення ми можемо відтворити . На останній стадії з метою отримання z якомога ближче до неспотвореного входу виконується алгоритм мінімізації. Похибка відтворення може бути або перехресно-ентропійною втратою з афінно-сигмоїдним декодувальником, або квадратично-похибковою втратою з афінним декодувальником.[171]

Для отримання глибинної архітектури автокодувальники накладають один поверх іншого.[172] Щойно кодувальну функцію першого знешумлювального автокодувальника навчено і використано для знеспотворення входу (спотвореного входу), ми можемо тренувати наступний рівень.[171]

Щойно складений автокодувальник натреновано, його вихід може бути використано як вхід до алгоритму керованого навчання, такого як класифікатор методом опорних векторів або багатокласова логістична регресія.[171]

Глибинні складальні мережі

Однією з глибинних архітектур, що ґрунтуються на ієрархії блоків спрощених модулів нейронних мереж, є глибинна опукла мережа, представлена 2011 року.[173] Тут задача навчання вагових коефіцієнтів формулюється як задача опуклої оптимізації із розв'язком замкненого вигляду. Цю архітектуру також називають глибинною складальною мережею (ГСМ, англ. deep stacking network, DSN),[174] підкреслюючи схожість цього механізму на складене узагальнення (англ. stacked generalization).[175] Кожен блок ГСМ є простим модулем, який легко навчати сам по собі керованим чином без зворотного поширення для цілих блоків.[176]

Згідно розробки Дена та Дона,[173] кожен блок складається зі спрощеного багатошарового перцептрону (БШП) з єдиним прихованим шаром. Прихований шар h має логістичні сигмоїдальні вузли, а вихідний шар має лінійні вузли. З'єднання між цими шарами представляються ваговою матрицею U; з'єднання з вхідного до прихованого шару мають вагову матрицю W. Цільові вектори t формують стовпчики матриці T, а вектори вхідних даних x формують стовпчики матриці X. Матрицею прихованих вузлів є . Модулі тренуються по черзі, отже вагові коефіцієнти нижчого рівня W на кожному етапі є відомими. Функція виконує поелементну логістичну сигмоїдну дію. Кожен із блоків оцінює один і той самий клас кінцевих міток y, і його оцінка поєднується із первинним входом X, формуючи розширений вхід для наступного блоку. Таким чином, вхід до першого блоку містить лише первинні дані, тоді як входи блоків нижче за течією мають також і виходи попередніх блоків. Тоді навчання вагової матриці U вищого рівня при заданих вагових коефіцієнтах в мережі може бути сформульовано як задачу опуклої оптимізації:

що має розв'язок замкненого вигляду.

На відміну від інших глибинних архітектур, таких як ГМП, метою є не відкриття перетворених представлень ознак. Структура ієрархії цього типу архітектури робить паралельне тренування прямолінійним, як задачу оптимізації в пакетному режимі. В чисто розрізнювальних задачах ГСМ працюють краще за звичайні ГМП.[174]

Тензорні глибинні складальні мережі

Ця архітектура є розширенням глибинних складальних мереж (ГСМ). Вона покращує ГСМ двома важливими шляхами: вона використовує інформацію вищого порядку з коваріаційних статистик, і перетворює неопуклу задачу нижчого рівня на опуклу підзадачу вищого рівня.[177] ТГСМ використовують коваріаційні статистики даних за допомогою білінійного відображення з обох із двох окремих наборів прихованих вузлів одного й того ж рівня на передбачення, через тензор третього порядку.

Хоча розпаралелювання та масштабованість і не розглядаються серйозно в звичайних ГНМ,[178][179][180] все навчання ГСМ і ТГСМ здійснюється в пакетному режимі, уможливлюючи розпаралелювання на кластерах вузлів центральних та графічних процесорів.[173][174] Розпаралелювання дозволяє масштабувати цю конструкцію на більші (глибші) архітектури та набори даних.

Основна архітектура є придатною для різнопланових задач, таких як класифікація та регресія.

Піково-пластинні обмежені машини Больцмана

Потреба в глибинному навчанні із дійснозначними входами, як у ґаусових обмежених машинах Больцмана, вмотивовує піково-пластинні ОМБ (ппОМБ, англ. spike and slab Restricted Boltzmann machine, ssRBM), які моделюють безперервнозначні входи зі строго двійковими латентними змінними.[181] Подібно до базової ОМБ та її варіантів, піково-пластинна ОМБ є двочастковим графом, але як у ҐОМБ, видимі вузли (входи) є дійснозначними. Відмінність є в прихованому шарі, де кожен прихований вузол має змінну двійкового піку та змінну дійснозначної пластини. Пік є дискретною масою ймовірності на нулі, тоді як пластина є густиною ймовірності над безперервною областю визначення;[182] їхня суміш формує апріорне. Ці терміни походять зі статистичної літератури.[183]

Розширення ппОМБ, що називається µ-ппОМБ, забезпечує додаткові моделювальні потужності, використовуючи додаткові члени в енергетичній функції. Один із цих членів дає моделі можливість формувати умовний розподіл пікових змінних знеособленням пластинних змінних при заданому спостереженні.

Змішані ієрархічно-глибинні моделі

Змішані ієрархічно-глибинні моделі (англ. compound hierarchical-deep models, compound HD models) складають глибинні мережі з непараметричних баєсових моделей. Ознаки можуть навчатися із застосуванням таких глибинних архітектур як ГМП,[91] ГМБ,[168] глибинні автокодувальники,[184] згорткові варіанти,[185][186] ппОМБ,[182] мережі глибинного кодування,[187] ГМБ з розрідженим навчанням ознак,[188] рекурентні нейронні мережі,[189] умовні ГМП,[190] знешумлювальні автокодувальники.[191] Це забезпечує краще представлення, уможливлюючи швидше навчання та точнішу класифікацію із даними високої розмірності. Проте ці архітектури є слабкими в навчанні нововведених класів на кількох прикладах, оскільки всі вузли мережі залучено до представлення входу (розподілені представлення), і мусить бути кориговано разом (високий ступінь свободи). Обмеження ступеню свободи знижує кількість параметрів для навчання, допомагаючи навчанню нових класів з кількох прикладів. Ієрархічні баєсові (ІБ) моделі (англ. Hierarchical Bayesian (HB) models) забезпечують навчання з кількох прикладів, наприклад,[192][193][194][195][196] для комп'ютерного бачення, статистики та когнітивної науки.

Змішані ІГ-архітектури мають на меті поєднання характеристик як ІБ, так і глибинних мереж. Змішана архітектура ІПД-ГМБ, ієрархічний процес Діріхле (ІПД) як ієрархічна модель, об'єднана з архітектурою ГМБ. Вона є повністю породжувальною моделлю, узагальненою з абстрактних понять, що течуть крізь шари моделі, яка є здатною синтезувати нові приклади нововведених класів, що виглядають досить природними. Всі рівні навчаються спільно, шляхом максимізації функції внеску логарифмічної ймовірності.[197]

У ГМБ з трьома прихованими шарами ймовірністю видимого входу ν є

де є набором прихованих вузлів, а є параметрами моделі, що представляють умови симетричної взаємодії видимі-приховані та приховані-приховані.

Після того, як модель ГМБ навчено, ми маємо неорієнтовану модель, що визначає спільний розподіл . Одним із шляхів вираження того, що було навчено, є умовна модель та апріорний член .

Тут представляє умовну модель ГМБ, що може розглядатися як двошарова ГМБ, але з умовами зсуву, що задаються станами :

Глибинні кодувальні мережі

Існують переваги моделі, яка може активно уточнювати себе з контексту в даних. Глибинна кодувальна мережа (ГПКМ, англ. deep coding network, DPCN) є передбачувальною схемою кодування, в якій спадна інформація використовується для емпіричного підлаштовування апріорних, необхідних для процедури висхідного висновування засобами глибинної локально з'єднаної породжувальної моделі. Це працює шляхом виділяння розріджених ознак зі спостережень, що змінюються в часі, із застосуванням лінійної динамічної моделі. Потім для навчання інваріантних представлень ознак застосовується стратегія агрегування (англ. pooling). Ці блоки складаються разом, щоби сформувати глибинну архітектуру, і тренуються жадібним пошаровим спонтанним навчанням. Шари утворюють щось на зразок марковського ланцюга, такого, що стани на будь-якому шарі залежать лише від наступного та попереднього шарів.

Глибинна передбачувальна кодувальна мережа (ГПКМ, англ. Deep predictive coding network, DPCN)[198] передбачує представлення шару, використовуючи спадний підхід із застосуванням інформації з верхнього шару та тимчасових залежностей з попередніх станів.

ГПКМ можливо розширити таким чином, щоби утворити згорткову мережу.[198]

Глибинні Q-мережі

Глибинна Q-мережа (англ. deep Q-network, DQN) — це тип моделі глибинного навчання, розроблений в Google DeepMind, який поєднує глибинну згорткову нейронну мережу з Q-навчанням, різновидом навчання з підкріпленням. На відміну від раніших агентів навчання з підкріпленням, глибинні Q-мережі можуть навчатися безпосередньо з сенсо́рних входів високої розмірності. Попередні результати було представлено 2014 року, а саму працю опубліковано 2015 року в Nature.[199] Обговорюване в цій праці застосування обмежувалося грою в ігри Atari 2600, але значення для інших потенційних застосувань є глибоким.

Мережі з пам'яттю

Поєднання зовнішньої пам'яті зі штучними нейронними мережами бере свій початок у ранніх дослідженнях розподілених представлень[200] та самоорганізаційних відображень. Наприклад, у розрідженій розподіленій пам'яті та ієрархічній часовій пам'яті зразки, закодовані нейронними мережами, використовуються як адреси для асоціативної пам'яті, з «нейронами», що по суті слугують шифраторами та дешифраторами адреси.

Диференційовні структури пам'яті, пов'язані з ДКЧП

Окрім довгої короткочасної пам'яті (ДКЧП), диференційовну пам'ять до рекурентних функцій також додали й інші підходи 1990-х та 2000-х років. Наприклад:

- Диференційовні дії проштовхування та виштовхування для мереж альтернативної пам'яті, що називаються нейронними стековими машинами (англ. neural stack machines)[201][202]

- Мережі пам'яті, в яких зовнішнє диференційовне сховище керівної мережі знаходиться у швидких вагових коефіцієнтах іншої мережі[203]

- «Забувальні вентилі» ДКЧП[204]

- Автореферентні рекурентні нейронні мережі (РНМ) з особливими вихідними вузлами для адресування та швидкого маніпулювання кожним із власних вагових коефіцієнтів РНМ на диференційовний манір (внутрішнє сховище)[205][206]

- Навчання перетворення з необмеженою пам'яттю[207]

Семантичне хешування

Підходи, які представляють попередній досвід безпосередньо, і використовують схожий досвід для формування локальної моделі, часто називають методами найближчого сусіда або k найближчих сусідів.[208] Зовсім недавно було показано, що глибинне навчання є корисним у семантичному хешуванні (англ. semantic hashing),[209] де з великого набору документів отримується глибинна графова модель векторів кількостей слів.[210] Документи відображуються на комірки пам'яті таким чином, що семантично схожі документи розташовуються за близькими адресами. Потім документи, схожі на документ із запиту, можна знаходити шляхом простого доступу до всіх адрес, що відрізняються від адреси документа із запиту лише кількома бітами. На відміну від розрідженої розподіленої пам'яті, що оперує 1000-бітними адресами, семантичне хешування працює на 32- або 64-бітних адресах, на яких ґрунтується традиційна комп'ютерна архітектура.

Нейронні машини Тюрінга

Нейронні машини Тюрінга (англ. Neural Turing machines),[211] розроблені в Google DeepMind, спаровують мережі ДКЧП із зовнішніми ресурсами пам'яті, з якими вони можуть взаємодіяти за допомогою процесів уваги (англ. attentional processes). Ця зв'язана система є аналогічною машині Тюрінга, але є диференційовною з краю в край, що дозволяє їй дієво навчатися градієнтним спуском. Попередні результати показують, що нейронні машини Тюрінга можуть виводити з прикладів входу та виходу прості алгоритми, такі як копіювання, впорядкування та асоціативне пригадування.

Мережі з пам'яттю

Мережі з пам'яттю (англ. memory networks)[212][213] є іншим розширенням нейронних мереж, що включає довготривалу пам'ять, розроблену командою дослідників Facebook. Довготривала пам'ять може читатися або записуватися з метою використання її для передбачення. Ці моделі застосовувалися в контексті питально-відповідальних систем (англ. question answering, QA), де довготривала пам'ять ефективно діє як (динамічна) база знань, а вихід є текстовою відповіддю.[214]

Вказівникові мережі

Глибинні мережі може бути потенційно поліпшено, якщо вони стануть глибшими та матимуть менше параметрів, зберігаючи здатність до навчання. В той час як тренування надзвичайно глибоких (наприклад, завглибшки в мільйон шарів) нейронних мереж може бути практично нездійсненним, ЦП-подібні архітектури, такі як вказівникові мережі (англ. pointer networks)[215] та нейронні машини з довільним доступом (англ. neural random-access machines),[216] розроблені дослідниками з Google Brain, долають це обмеження завдяки застосуванню зовнішньої пам'яті з довільним доступом, а також додаванню інших складових, що зазвичай належать до комп'ютерної архітектури, таких як регістри, АЛП та вказівники. Такі системи працюють на векторах розподілів імовірностей, що зберігаються в комірках пам'яті та регістрах. Таким чином, ця модель є повністю диференційовною, й тренується з краю в край. Ключовою характеристикою цих моделей є те, що їхня глибина, розмір їхньої короткочасної пам'яті та їхня кількість параметрів можуть змінюватися незалежно — на відміну від моделей на кшталт ДКЧП, чия кількість параметрів зростає квадратично з розміром пам'яті.

Кодувально-декодувальні мережі

Кодувально-декодувальна схема (англ. encoder–decoder framework) є схемою на основі нейронних мереж, спрямованою на відображення високоструктурованого входу на високоструктурований вихід. Її було запропоновано нещодавно в контексті машинного перекладу,[217][218][219] де вхід та вихід є писаними реченнями двома природними мовами. В тій праці рекурентна нейронна мережа] (РНМ) або згорткова нейронна мережа (ЗНМ) з ДКЧП використовувалася як кодувальник для отримання зведення про вхідне речення, і це зведення декодувалося умовною РНМ-моделлю мови (англ. recurrent neural network language model, RNN-LM) для продукування перекладу.[220] Всі ці системи мають однакові будівельні блоки: вентильні (англ. gated) РНМ та ЗНМ, і треновані механізми уваги.

Інші архітектури

Багатошарова ядрова машина

Багатошарові ядрові машини (БЯМ, англ. Multilayer Kernel Machine, MKM), як представлено в [221], є способом навчання високо нелінійних функцій за допомогою ітеративного застосування слабко нелінійних ядер. Вони використовують ядровий метод головних компонент (ЯМГК, англ. kernel principal component analysis, KPCA), у [222], як метод для спонтанного жадібного пошарового передтренувального кроку архітектури глибинного навчання.

-й шар навчається представлення попереднього шару , виділяючи головних компонент (ГК, англ. principal component, PC) проекції в область визначення ознак шару , виведеної ядром. Заради зниження в кожному шарі розмірності уточненого представлення пропонується керована стратегія для вибору найінформативніших ознак серед виділених ЯМГК. Цей процес є таким:

- вишикувати ознаки відповідно до їхньої взаємної інформації з мітками класів;

- для різних значень K та обчислити похибку класифікації методом K найближчих сусідів, використовуючи лише найінформативніших ознак на затверджувальному наборі;

- значення , з яким класифікатор досяг найнижчого рівня похибки, визначає кількість ознак для збереження.

Застосування ЯМГК як будівельних блоків для БЯМ має деякі недоліки.

Дослідниками Microsoft для застосувань у розумінні усного мовлення було розроблено простіший спосіб застосування ядрових машин до глибинної архітектури.[223] Головна ідея полягає у використанні ядрової машини для наближення поверхневої нейронної мережі з нескінченною кількістю прихованих вузлів, і подальшому застосуванні складання для зрощування виходу ядрової машини та сирого входу при побудові наступного, вищого рівня ядрової машини. Кількість рівнів у цій глибинній опуклій мережі є гіперпараметром системи в цілому, який повинен визначатися перехресною перевіркою.

Застосування

Автоматичне розпізнавання мовлення

В розпізнаванні мовлення було вчинено революцію глибинним навчанням, особливо довгою короткочасною пам'яттю (ДКЧП), рекурентною нейронною мережею, опублікованою Зеппом Хохрайтером та Юргеном Шмідгубером 1997 року.[53] РНМ ДКЧП обходить проблему зникання градієнту, і може навчатися задач «дуже глибокого навчання»,[5] які включають події мовлення, розділені тисячами дискретних кроків часу, коли один крок часу відповідає близько 10 мс. 2003 року ДКЧП із забувальними вентилями (англ. forget gates)[107] в деяких задачах стала конкурентоспроможною в порівнянні з традиційними розпізнавачами мовлення.[54] 2007 року ДКЧП, тренована нейромережевою часовою класифікацією (НЧК, англ. Connectionist Temporal Classification, CTC),[55] досягла відмінних результатів у деяких застосуваннях,[56] хоча комп'ютери тоді були значно повільнішими за сьогоднішні. 2015 року велике розпізнавання мовлення Google раптом майже подвоїло свою продуктивність через ДКЧП, треновані НЧК, і тепер є доступною користувачам усіх смартфонів.[57]

В таблиці нижче наведено результати автоматичного розпізнавання мовлення на популярному англомовному наборі даних TIMIT. Він є звичайним набором даних, що застосовується для початкових оцінок архітектур глибинного навчання. Набір у цілому включає 630 мовців з восьми основних діалектів американської англійської, де кожен мовець читає 10 різних речень.[224] Його невеликий розмір дозволяє ефективно випробовувати багато конфігурацій. Що ще важливіше, задача TIMIT розглядає розпізнавання фональних послідовностей, що, на відміну від розпізнавання словесних послідовностей, дозволяє дуже слабкі «мовні моделі», і відтак спрощує аналіз слабкостей аспектів акустичного моделювання розпізнавання мовлення. Такий аналіз на TIMIT Лі Дена зі співробітниками близько 2009—2010 років, протиставляючи моделі ҐСМ (та інших породжувальних моделей мовлення) з ГНМ, стимулював ранні промислові інвестиції в глибинне навчання для розпізнавання мовлення від малих до великих масштабів,[50][70] зрештою привівши до поширеного та домінантного застосування в цій галузі. Цей аналіз було здійснено з порівнянною ефективністю (менше 1.5 % в рівні похибок) між розрізнювальними ГНМ та породжувальними моделями. Перелічені нижче рівні похибок, включно з цими ранніми результатами, виміряні як рівень фональних похибок (РФП, англ. phone error rates, PER), було узагальнено за проміжок часу крайніх 20 років:

| Метод | РФП (%) |

|---|---|

| РНМ з випадковими початковими значеннями | 26.1 |

| Баєсова трифональна ҐСМ-ПММ | 25.6 |

| Модель прихованої траєкторії (породжувальна) | 24.8 |

| Монофональна ГНМ з випадковими початковими значеннями | 23.4 |

| Монофональна ГМП-ГНМ | 22.4 |

| Трифональна ҐСМ-ПММ з тренуванням ПМВІ | 21.7 |

| Монофональна ГМП-ГНМ на блоці фільтрів | 20.7 |

| Згорткова ГНМ[225] | 20.0 |

| Згорткова ГНМ з різнорідним агрегуванням | 18.7 |

| Ансамблева ГНМ/ЗНМ/РНМ[226] | 18.2 |

| Двоспрямована ДКЧП | 17.9 |

2010 року промислові дослідники розширили глибинне навчання з TIMIT до великого словникового розпізнавання мовлення, пристосувавши великі вихідні шари ГНМ на основі станів контекстно-залежних ПММ, побудованих деревами рішень.[227][228] Усебічні огляди цієї розробки та положення справ станом на жовтень 2014 року подано в недавній книзі видавництва Springer від Microsoft Research.[71] У ранішій статті [229] було зроблено огляд обстановки в автоматичному розпізнаванні мовлення та впливі різних парадигм машинного навчання, включно із глибинним навчанням.

Одним із основоположних принципів глибинного навчання є покінчити з ручним конструюванням ознак, і використовувати сирі ознаки. Цей принцип було вперше успішно досліджено в архітектурі глибинного автокодувальника на «сирій» спектрограмі або ознаках лінійного блока фільтрів,[230] що показало його перевагу над мел-кепстровими ознаками, які містять мало етапів незмінного перетворення зі спектрограм. Зовсім недавно було показано, що «справжні» ознаки мовлення, хвилеформи, дають відмінні результати результати у великомасштабному розпізнаванні мовлення.[231]

З моменту початкового успішного дебюту ГНМ у розпізнаванні мовлення близько 2009—2011 років та ДКЧП близько 2003—2007 років, було здійснено величезні нові зрушення. Прогрес (та майбутні напрямки) може бути зведено у вісім основних областей:[2][52][71]

- Масштабування вгору/назовні та прискорення тренування ГНМ та декодування;

- Послідовнісно розрізнювальне тренування ГНМ;

- Обробка ознак глибинними моделями з цілісним розумінням механізмів, що лежать в їх основі;

- Пристосування ГНМ та споріднених глибинних моделей;

- Багатозадачне навчання та передавальне навчання ГНМ і спорідненими глибинними моделями;

- Згорткові нейронні мережі, та як проектувати їх для найкращого використання знань про область мовлення;

- Рекурентна нейронна мережа та її цінні ДКЧП-варіанти;

- Інші типи глибинних моделей, включно з моделями на основі тензорів та комбінованими породжувально/розрізнювальними моделями.

Великомасштабне автоматичне розпізнавання мовлення є першим і найпереконливішим прикладом застосування глибинного навчання в недавній історії, що використовується як в промисловості, так і в науці, в усіх напрямках. Між 2010 та 2014 роками дві важливі конференції з обробки сигналів та розпізнавання мовлення, IEEE-ICASSP та Interspeech, побачили значне збільшення кількостей прийнятих праць серед усіх праць на цих конференціях за рік на тему глибинного навчання для розпізнавання мовлення. Що ще важливіше, всі важливі комерційні системи розпізнавання мовлення (наприклад, Microsoft Cortana, Xbox, Перекладач Skype, Amazon Alexa, Google Now, Apple Siri, голосовий пошук Baidu та iFlyTek та ряд мовленневих продуктів Nuance тощо) ґрунтуються на моделях глибинного навчання.[2][232][233][234] Див. також нещодавнє інтерв'ю ЗМІ з технічним директором Nuance Communications.[235]

Розпізнавання зображень

Звичайним набором для оцінки класифікації зображення є набір даних MNIST. Він складається з рукописних цифр, і включає 60 000 тренувальних зразків та 10 000 перевіркових зразків. Як і в TIMIT, його малий розмір дозволяє перевіряти кілька конфігурацій. Повний перелік результатів на цьому наборі можна знайти в [236]. Поточним найкращим результатом на MNIST є рівень похибки 0.23 %, досягнений Чирешаном та ін. 2012 року.[237]

Згідно ЛеКуна,[68] на початку 2000-х років у промисловому застосуванні ЗНМ вже обробляли приблизно від 10 % до 20 % усіх перевірок, написаних у США на початку 2000-х років. Значний додатковий вплив глибинного навчання в розпізнаванні зображень або об'єктів відчувся в 2011—2012 роках. І хоча ЗНМ, треновані зворотним поширенням, займали помітне місце десятиріччями,[34] а реалізації НМ, включно із ЗНМ,[74] на ГП — роками, знадобилися швидкі реалізації на ГП ЗНМ з максимізаційними підвибірками в стилі Дена Чирешана з колегами,[95] щоби зробити зарубку на комп'ютерному баченні.[5] 2011 року цей підхід вперше досяг надлюдської продуктивності у змаганні з розпізнавання візуальних образів.[97] Також 2011 року він переміг у змаганні ICDAR з розпізнавання китайського рукописного тексту, а в травні 2012 року переміг у змаганні ISBI з сегментування зображень.[98] До 2011 року ЗНМ не відігравали провідної ролі на конференціях із комп'ютерного бачення, але в червні 2012 року праця Дена Чирешана та ін. на провідній конференції CVPR[100] показала, як різко максимізаційно-підвибіркові ЗНМ на ГП можуть покращити багато еталонних рекордів бачення, іноді з порівняною з людською, або навіть із надлюдською продуктивністю. В жовтні 2012 року подібна система Алекса Крижевського в команді Джефа Хінтона[99] виграла великомасштабне змагання ImageNet зі значним відривом від методів поверхневого машинного навчання. В листопаді 2012 року система Чирешана та ін. також виграла змагання ICPR з аналізу великих медичних зображень для виявлення раку, а наступного року також і MICCAI Grand Challenge з цього ж предмету.[238] В 2013 та 2014 роках рівень похибки на задачі ImageNet із застосуванням глибинного навчання було швидко додатково скорочено, слідом за подібною тенденцією у великомасштабному розпізнаванні мовлення.

Як і в амбітному русі від автоматичного розпізнавання мовлення до його автоматичного перекладу та розуміння, класифікацію зображень нещодавно було розширено до складнішої задачі опису зображень, в якій глибинне навчання (часто як поєднання ЗНМ та ДКЧП) є важливою підлеглою технологією.[239][240][241][242]

Одним із прикладів застосування є автомобільний комп'ютер, нібито натренований глибинним навчанням, який може дозволити автомобілям інтерпретувати зображення з 360-градусних камер.[243] Іншим прикладом є технологія, відома як новітній аналіз у лицевій дисморфології (англ. Facial Dysmorphology Novel Analysis, FDNA), що застосовується для аналізу випадків пороків розвитку в людей, пов'язаного з великою базою даних генетичних синдромів.

Обробка природної мови

Нейронні мережі застосовуються для реалізації моделей мов з початку 2000-х років.[108][244] Рекурентні нейронні мережі, особливо ДКЧП,[53] підходять найкраще для послідовних даних, таких як мова. ДКЧП допомогла поліпшити машинний переклад[109] та моделювання мов.[110][111] ДКЧП у поєднанні з ЗНМ також поліпшили автоматичний опис зображень[142] та безліч інших застосувань.[5]