Похибки та залишки

У статистиці та оптимізації по́хибки (англ. errors) та за́лишки (англ. residuals) є тісно пов'язаними мірами відхилення спостережуваного значення елементу вибірки від його «теоретичного значення», які легко сплутати. Похибка (або збу́рення) спостережуваного значення є відхиленням цього спостережуваного значення від (не спостережуваного) істинного значення досліджуваної величини (наприклад, середнього значення генеральної сукупності), а залишком спостережуваної змінної є різниця між цим спостережуваним значенням та оцінкою значення досліджуваної величини (наприклад, середнім значенням вибірки). Найважливішою ця відмінність є в регресійному аналізі, де вона приводить до поняття стьюдентизованих залишків.

| Частина з циклу Статистика |

| Регресійний аналіз |

|---|

|

| Моделі |

|

|

|

|

|

| Оцінка |

|

|

| Підґрунтя |

|

Введення

Припустімо, що є ряд спостережень з одновимірного розподілу, і ми хочемо оцінити середнє значення цього розподілу (так звану модель зсуву). В цьому випадку похибки є відхиленнями спостережень від середнього значення сукупності, а залишки є відхиленнями спостережень від середнього значення вибірки.

Статистична похибка (або збурення) є величиною, на яку спостереження відрізняється від його математичного сподівання, коли останнє ґрунтується на всій сукупності, з якої було випадково вибрано об'єкт статистичного спостереження. Наприклад, якщо середній зріст в загальній сукупності 21-річних чоловіків є 1.75 метрів, і один випадково вибраний чоловік має зріст 1.80 метрів, то «похибка» є 0.05 метрів; якщо випадково вибраний чоловік має зріст 1.70 метрів, то «похибка» є -0.05 метрів. Математичне сподівання, будучи середнім арифметичним всієї сукупності, є зазвичай неспостережним, і отже статистичну похибку також неможливо спостерігати.

З іншого боку, залишком (або відхиленням допасованості) є спостережувана оцінка неспостережуваної статистичної похибки. Розгляньмо попередній приклад зі зростами чоловіків, і припустімо, що ми маємо випадкову вибірку з n людей. Гарною оцінкою середнього значення сукупності могло би слугувати вибіркове середнє. В такому разі ми маємо:

- Відмінність зросту кожного чоловіка у вибірці від неспостережуваного середнього значення сукупності є статистичною похибкою, тоді як

- Відмінність зросту кожного чоловіка у вибірці від спостережуваного середнього значення вибірки є залишком.

Зауважте, що сума залишків у випадковій вибірці обов'язково є нульовою, і тому залишки є обов'язково не незалежними. З іншого боку, статистичні похибки є незалежними, і їхня сума в межах випадкової вибірки майже напевно є ненульовою.

Можна стандартизувати статистичні похибки (особливо нормального розподілу) за z-оцінкою (або «стандартизованою оцінкою»), і стандартизувати залишки за t-статистикою, або, загальніше, стьюдентизованими залишками.

В одновимірних розподілах

Якщо ми розглядаємо нормально розподілену сукупність із середнім значенням μ та стандартним відхиленням σ, і вибираємо осіб незалежно, то ми маємо

є випадковою змінною, розподіленою таким чином:

Тоді статистичні похибки є

а залишки є

Сума квадратів статистичних похибок, поділена на σ2, має розподіл хі-квадрат з n ступенями вільності:

Проте ця величина не є спостережною. З іншого боку, сума квадратів залишків є спостережною. Частка від ділення цієї суми на σ2 має розподіл хі-квадрат з лише n − 1 ступенями вільності:

Ця різниця між n та n − 1 ступенями вільності має наслідком поправку Бесселя для оцінки дисперсії вибірки із сукупності з невідомим середнім значенням та невідомою дисперсією, хоча якщо середнє значення є відомим, то поправка не потрібна.

Зауваження

Примітно, що може бути показано, наприклад, за допомогою теореми Басу, що сума квадратів залишків та середнє значення вибірки є незалежними одне від одного. Цей факт, а також наведені вище нормальний та хі-квадратичний розподіли, формують основу обчислень із залученням дробу

який, як правило, називають t-статистикою.

Розподіли ймовірності чисельника та знаменника окремо залежать від значення неспостережуваного стандартного розподілу сукупності σ, але σ з'являється як в чисельнику, так і в знаменнику, і скорочується. Це вдача, оскільки це означає, що, незважаючи на те, що ми не знаємо σ, ми знаємо розподіл імовірності цієї частки: вона має t-розподіл Стьюдента з n − 1 ступенями вільності. Отже, ми можемо застосовувати цю частку для знаходження довірчого інтервалу μ.

Регресії

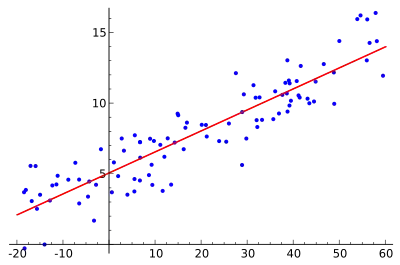

В регресійному аналізі відмінність між похибками та залишками є тонкою та важливою, і приводить до поняття стьюдентизованих залишків. Якщо дано неспостережувану функцію, що ставить у відповідність незалежну змінну до залежної, — скажімо, лінію, — то відхилення спостережень залежної змінної від цієї функції є неспостережуваними похибками. Якщо запустити регресію на якихось даних, то відхилення спостережень залежної змінної від допасованої функції є залишками.

Проте термінологічна різниця проявляється у вираженні середньоквадратичної похибки (СКП, англ. MSE). Середньоквадратична похибка регресії є числом, обчисленим як сума квадратів обчислених залишків, а не неспостережуваних похибок. Якщо цю суму квадратів поділити на n, кількість спостережень, то результатом буде середнє значення квадратичних залишків. Оскільки це є упередженою оцінкою дисперсії неспостережуваних похибок, упередження усувається множенням середнього значення квадратичних залишків на n / df, де df є числом ступенів вільності (n мінус кількість оцінюваних параметрів). Цей метод дає такий точно результат, як і метод із застосуванням середнього значення квадратичних похибок. Крайня формула служить неупередженою оцінкою дисперсії неспостережуваних похибок, і називається середньоквадратичною похибкою.[1]

Інший метод обчислення середнього квадрату похибки при аналізі дисперсії лінійної регресії із застосуванням такого прийому, як застосовується в дисперсійному аналізі (вони однакові, оскільки дисперсійний аналіз є одним з типів регресії), сума квадратів залишків (відома також як сума квадратів похибки) ділиться на ступені вільності (де ступені вільності дорівнюють n-p-1, де p є числом «параметрів», або провісників, що використовуються в моделі, тобто кількістю змінних у рівнянні регресії). Також можна обчислювати середній квадрат моделі діленням суми квадратів моделі мінус ступені вільності, що є просто кількістю параметрів. Тоді значення F може обчислюватися діленням СК(моделі) на СК(похибки), і ми можемо визначати значущість (ось для чого починати з середніх квадратів.).[2]

Тим не менш, через поведінку процесу регресії розподіли залишків у різних точках даних (вхідного масиву) можуть різнитися, навіть якщо самі похибки мають ідентичні розподіли. Конкретно, в лінійній регресії, в якій похибки мають ідентичні розподіли, мінливість залишків входів у середині області визначення буде вищою, ніж мінливість залишків на її краях:[джерело?] лінійна регресія допасовується до крайових точок краще, ніж до середніх. Це відбивається також і на функціях впливу різних точок даних на коефіцієнти регресії: крайові точки мають більший вплив.

Таким чином, для порівняння залишків на різних входах необхідне регулювання залишків очікуваною мінливістю залишків, що називається стьюдентизацією. Це особливо важливо у випадку виявлення викидів: великий залишок може бути очікуваним в середині області визначення, але розглядатися як викид на її краях.

Інші застосування слова «похибка» у статистиці

Термін «похибка» при обговоренні в попередніх розділах застосовується в сенсі відхилення значення від гіпотетичного неспостережуваного значення. У статистиці зустрічаються щонайменше два інших застосування, і обидва мають на увазі похибки спостережуваного передбачення:

Середньоквадратична похибка, або середня квадратична похибка (скорочується як СКП, англ. MSE) та кореневе середньоквадратичне відхилення (КСКП, англ. RMSE) розглядають суму, на яку значення, передбачені оцінювачем, відрізняються від оцінюваних значень (зазвичай за межами вибірки, з якої робиться оцінка моделі).

Сума квадратичних похибок (англ. sum of squared errors, SSE або SSe), розглядає залишкову суму квадратів (суму квадратичних залишків) регресії; вона є сумою квадратів відхилень фактичних значень від передбачених в межах вибірки, що застосовується для оцінки. Аналогічно, сума абсолютних похибок (англ. sum of absolute errors, SAE) розглядає суму модулів значень залишків, що мінімізується в підході до регресії методом найменших модулів.

Див. також

- Міри розсіяння

- Вектор нововведень

- Похибка вимірювання

- Виявлення та виправлення помилок

- Імовірна похибка

- Кореневе середньоквадратичне відхилення

- Межа похибки

- Сума квадратів браку допасованості

- Нововведення (обробка сигналів)

- Похибка вибірки

- Помилки першого і другого роду

- Поширення похибки

- Пояснена сума квадратів

- Регресійне розведення

- Середня абсолютна похибка

- Стьюдентизований залишок

- Узгоджений прогноз

Примітки

- Steel, Robert G. D.; Torrie, James H. (1960). Principles and Procedures of Statistics, with Special Reference to Biological Sciences. McGraw-Hill. с. 288. (англ.)

- Zelterman, Daniel (2010). Applied linear models with SAS (вид. [Online-Ausg.].). Cambridge: Cambridge University Press. ISBN 9780521761598. (англ.)

Література

- Cook, R. Dennis; Weisberg, Sanford (1982). Residuals and Influence in Regression. (вид. Repr.). New York: Chapman & Hall. ISBN 041224280X. Процитовано 23 лютого 2013. (англ.)

- Weisberg, Sanford (1985). Applied Linear Regression (вид. 2nd). New York: Wiley. ISBN 9780471879572. Процитовано 23 лютого 2013. (англ.)

- Hazewinkel, Michiel, ред. (2001). Errors, theory of. Encyclopedia of Mathematics. Springer. ISBN 978-1-55608-010-4. (англ.)