Допасованість (статистика)

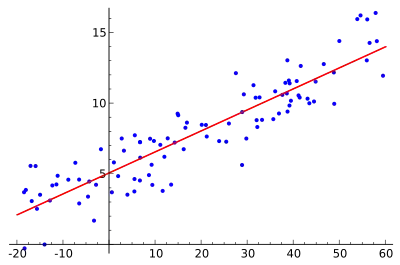

Допасо́ваність[1] (англ. goodness of fit) статистичної моделі описує, наскільки добре її допасовано до набору спостережень. Міри допасованості зазвичай роблять підсумок незгідності між спостережуваними значеннями та значеннями, очікуваними за моделі, що розглядають. Такі міри можливо використовувати в перевірці статистичних гіпотез, наприклад, для перевірки нормальності залишків, для перевірки того, чи дві вибірки вибрано з ідентичних розподілів (див. критерій Колмогорова — Смирнова), чи для перевірки того, чи слідують виходові частоти певному розподілові (див. критерій хі-квадрат Пірсона). В дисперсійному аналізі однією зі складових, на яку розбивають дисперсію, може бути сума квадратів браку допасованості.

| Частина з циклу Статистика |

| Регресійний аналіз |

|---|

|

| Моделі |

|

|

|

|

|

| Оцінка |

|

|

| Підґрунтя |

|

Допасованість розподілів

При оцінюванні того, чи підходить даний розподіл до набору даних, можливо використовувати наступні критерії та міри допасованості, що лежать в їх основі:

- Баєсів інформаційний критерій

- Критерій Колмогорова — Смирнова

- Критерій Крамера — фон Мізеса

- Критерій Андерсона — Дарлінга

- Критерій Шапіро — Вілка

- Критерій хі-квадрат

- Інформаційний критерій Акаіке

- Критерій Госмера — Лемешова

- Критерій Куйпера

- Ядрована незгідність Штайна (англ. kernelized Stein discrepancy)[2][3]

- Критерії Чжана ZK, ZC та ZA (англ. Zhang's ZK, ZC and ZA tests)[4]

- Критерій Морана

Регресійний аналіз

В регресійному аналізі до допасованості мають стосунок такі предмети:

- Коефіцієнт детермінації (міра допасованості R-квадрат);

- Сума квадратів браку допасованості;

- Зменшена статистика хі-квадрат.

- Затверджування регресії

- Критерій Cp Меллоуза

Категорійні дані

Далі наведено приклади, що виникають у контексті категорійних даних.

Критерій хі-квадрат Пірсона

Критерій хі-квадрат Пірсона використовує міру допасованості, яка є сумою різниць між спостережуваними та очікуваними виходовими частотами (тобто, кількостями спостережень), кожну з яких піднесено до квадрату, й поділено на очікувану:

де

- Oi = спостережувана кількість для засіку (англ. bin) i

- Ei = очікувана кількість для засіку i, підтримувана нульовою гіпотезою.

Очікувану частоту обчислюють як

де

- F = кумулятивна функція розподілу ймовірності для розподілу ймовірності, що перевіряють.

- Yu = верхня (англ. upper) межа класу i,

- Yl = нижня (англ. lower) межа класу i,

- N = розмір вибірки

Отримуване в результаті значення можливо порівнювати з розподілом хі-квадрат для визначення допасованості. Розподіл хі-квадрат має (k − c) ступенів вільності, де k є числом не порожніх комірок, а c є числом оцінюваних параметрів розподілу (включно з параметрами положення, масштабу та форми) плюс один. Наприклад, для 3-параметрового розподілу Вейбула, c = 4.

Приклад: однакові частоти чоловіків та жінок

Наприклад, щоби перевірити гіпотезу, що випадкову вибірку зі 100 людей вибрано із сукупності, в якій чоловіки та жінки є рівними за частотою, спостережуване число чоловіків та жінок порівнюватиметься з теоретичними частотами 50 чоловіків та 50 жінок. Якщо в вибірці було 44 чоловіки та 56 жінок, то

Якщо нульова гіпотеза є істинною (тобто, чоловіків та жінок вибирають з рівною частотою у вибірці), то перевірну статистику вибиратимуть з розподілу хі-квадрат з одним ступенем вільності. І хоча можна було би очікувати двох ступенів вільності (по одному для чоловіків та жінок), ми мусимо враховувати те, що загальне число чоловіків та жінок є обмеженим (100), і відтак є лише один ступінь вільності (2 − 1). Або ж, якщо кількість чоловіків є відомою, то кількість жінок є визначеною, і навпаки.

Результат звернення до розподілу хі-квадрат для 1 ступеню вільності показує, що ймовірність спостереження цієї відмінності (або екстремальнішої за цю), якщо чоловіки та жінки є однаково численними в генеральній сукупності, становить приблизно 0.23. Ця ймовірність є вищою за загальноприйнятий критерій статистичної значущості (.001-.05), тож звичайно ми не відкидатимемо нульову гіпотезу про те, що число чоловіків у сукупності є таким же, як і число жінок (тобто, ми розглядатимемо нашу вибірку як таку, що знаходиться в межах того, що ми би очікували для співвідношення чоловіків/жінок 50/50).

Зверніть увагу на припущення, що механізм, який породив цю вибірку, є випадковим, в сенсі незалежного випадкового вибирання з однаковою ймовірністю, тут 0.5 як для чоловіків, так і для жінок. Якщо ж, наприклад, кожен з обраних 44 чоловіків приведе приятеля-чоловіка, й кожна з обраних 56 жінок приведе приятельку-жінку, то кожне збільшиться в 4 рази, тоді як кожне збільшиться в 2 рази. Значення цієї статистики подвоїться до 2.88. Знаючи цей внутрішній механізм, ми, звісно, повинні були би рахувати пари. В загальному випадку, якщо механізм не є обґрунтовано випадковим, він буде невідомим. Розподіл, до якого повинно бути віднесено перевірну статистику, може, відповідно, дуже відрізнятися від розподілу хі-квадрат.[5]

Біноміальний випадок

Біноміальний експеримент є послідовністю незалежних проб, у якій проби можуть призводити в результаті до двох виходів, успіху чи відмови. Є n проб, кожна з імовірністю успіху, позначуваною через p. Якщо npi ≫ 1 для кожного i (де i = 1, 2, ..., k), то

Це приблизно має розподіл хі-квадрат з k − 1 ступенями вільності. Той факт, що ступенів вільності є k − 1, є наслідком обмеження . Ми знаємо, що є k спостережуваних лічильників клітин, проте щойно стають відомими будь-які k − 1, то один, що лишився, визначається однозначно. В принципі, можна сказати, що є лише k − 1 лічильників клітин, що визначаються вільно, звідси k − 1 ступенів вільності.

G-критерій

G-критерії є перевірками статистичної значущості відношенням правдоподібностей, які все ширше застосовують у ситуаціях, в яких раніше радили критерії хі-квадрат Пірсона.[6]

Загальною формулою G є

де та є тим же, що й для критерію хі-квадрат, позначує натуральний логарифм, а суму беруть над усіма не порожніми комірками. Крім того, загальна спостережена кількість повинна дорівнювати загальній очікуваній кількості:

де є загальним числом спостережень.

G-критерії почали радити щонайменше починаючи з випуску популярного статистичного підручника Роберта Р. Сокала та Ф. Джеймса Рольфа 1981 року.[7]

Див. також

- Всі моделі є неправильними

- Девіантність (статистика) (пов'язана з УЛМ)

- Перенавчання

- Затверджування статистичної моделі

- Оцінювач Тейла — Сена

- Функція допасованості

Примітки

- goodness of fit // Англійсько-українсько-англійський словник наукової мови (фізика та споріднені науки). Частина ІІ українсько-англійська / уклад. О. Кочерга, Є. Мейнарович. — 2010.

- Liu, Qiang; Lee, Jason; Jordan, Michael (20 червня 2016). A Kernelized Stein Discrepancy for Goodness-of-fit Tests. Proceedings of the 33rd International Conference on Machine Learning The 33rd International Conference on Machine Learning. New York, New York, USA: Proceedings of Machine Learning Research. с. 276–284. (англ.)

- Chwialkowski, Kacper; Strathmann, Heiko; Gretton, Arthur (20 червня 2016). A Kernel Test of Goodness of Fit. Proceedings of the 33rd International Conference on Machine Learning The 33rd International Conference on Machine Learning. New York, New York, USA: Proceedings of Machine Learning Research. с. 2606–2615. (англ.)

- Zhang, Jin (2002). Powerful goodness-of-fit tests based on the likelihood ratio. J. R. Stat. Soc. B 64: 281–294. Процитовано 5 листопада 2018. (англ.)

- Maindonald, J. H.; Braun, W. J. (2010). Data Analysis and Graphics Using R. An Example-Based Approach. (вид. Third). New York: Cambridge University Press. с. 116–118. ISBN 978-0-521-76293-9. (англ.)

- McDonald, J.H. (2014). G–test of goodness-of-fit. Handbook of Biological Statistics (вид. Third). Baltimore, Maryland: Sparky House Publishing. с. 53–58. (англ.)

- Sokal, R. R.; Rohlf, F. J. (1981). Biometry: The Principles and Practice of Statistics in Biological Research (вид. Second). W. H. Freeman. ISBN 0-7167-2411-1. (англ.)

Література

- Huber-Carol, C.; Balakrishnan, N.; Nikulin, M. S. та ін., ред. (2002). Goodness-of-Fit Tests and Model Validity. Springer. (англ.)

- Ingster, Yu. I.; Suslina, I. A. (2003). Nonparametric Goodness-of-Fit Testing Under Gaussian Models. Springer. (англ.)

- Rayner, J. C. W.; Thas, O.; Best, D. J. (2009). Smooth Tests of Goodness of Fit (вид. 2nd). Wiley. (англ.)

- Vexlera, Albert; Gurevich, Gregory (2010). Empirical likelihood ratios applied to goodness-of-fit tests based on sample entropy. Computational Statistics & Data Analysis 54: 531–545. doi:10.1016/j.csda.2009.09.025. (англ.)