Теорема Гаусса — Маркова

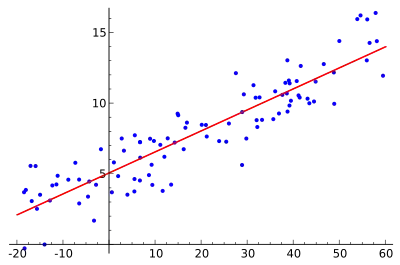

У статистиці, теорема Гаусса-Маркова (або просто теорема Гаусса для деяких акторів)[1] стверджує, що у звичайному методі найменших квадратів (ЗМНК) оцінювач має найменшу дисперсію вибірки в межах класу від лінійних неупереджених оцінок, якщо помилки у лінійній регресійній моделі є некорильованими, мають рівні дисперсії та очікуване значення нуля.[2] Помилки не повинні бути нормальними, вони також не повинні бути незалежними та однаково розподіленими (лише некорильованими із середнім нулем та гомосцедастичними з кінцевою дисперсією). Не можна відмовлятись від вимоги щодо неупередженості оцінювача, оскільки упереджені оцінювачі існують з меншою дисперсією. Дивіться, наприклад оцінювач Джеймса-Штейна (який також знижує лінійність), регресійну регресію, або просто будь-який вироджений оцінювач.

| Частина з циклу Статистика |

| Регресійний аналіз |

|---|

|

| Моделі |

|

|

|

|

|

| Оцінка |

|

|

| Підґрунтя |

|

Теорема була названа на честь Карла Фрідріха Гаусса та Андрія Маркова, хоча робота Гаусса значно передує роботі Маркова.[3] Але в той час, як Гаусс отримував результат, припускаючи незалежність і нормальність, Марков звів припущення до форми, зазначеної вище.[4] Подальше узагальнення до сферичних помилок дав Александер Ейткен.

Ствердження

Припустимо ми маємо матричні позначення,

розширюються до,

де не є випадковими, але un спостережуваних параметрів, є невипадковими та спостережуваними (їх називають «пояснювальними змінними»), випадкові, і так є випадковими. Випадкові величини називаються «порушенням», «шумом» або просто «помилкою» (буде протиставлено «залишковим» далі в статті; див. помилки та залишки в статистиці). Зверніть увагу, що для включення константи у вищенаведену модель можна ввести константу як змінну з нещодавно введеним останнім стовпцем X є одиницею, тобто для усіх . Зауважте, що хоча як вибіркові відповіді можна спостерігати наступні твердження та аргументи, включаючи припущення, докази та інші, припускають за єдиною умовою знання але не

Припущення Гаусса-Маркова стосуються безлічі помилок випадкових величин, :

- Вони мають середній нуль:

- Вони гомосцедастичні, тобто всі мають однакову кінцеву дисперсію: для усіх та

- Виразні терміни помилок не пов'язані між собою:

Лінійна оцінка є лінійною комбінацією

В якій коефіцієнтам не дозволяється залежати від базових коефіцієнтів , оскільки вони не спостерігаються, але дозволяється залежати від значень , оскільки ці дані є доступними. (Залежність коефіцієнтів від кожного типово нелінійна; оцінювач є лінійним у кожному а отже і в кожному випадковому саме тому це лінійна регресія.) Кажуть що оцінювач є неупередженим тоді і лише тоді

Незалежно від значень . А тепер нехай буде деякою лінійною комбінацією коефіцієнтів. Тоді середньоквадратична похибка відповідної оцінки становить

Іншими словами, це очікування квадрата зваженої суми (по параметрах) різниць між оцінювачами та відповідними параметрами, які слід оцінити. (Оскільки ми розглядаємо випадок, коли всі оцінки параметрів є неупередженими, ця середньоквадратична похибка така ж, як і дисперсія лінійної комбінації.) Найкращий лінійний неупереджений оцінювач (СИНІЙ) вектора параметрів є найменшою середньоквадратичною похибкою для кожного вектора параметрів лінійної комбінації. Це еквівалентно умов

Є позитивною напіввизначеною матрицею для кожного іншого лінійного неупередженого оцінювача .

Звичайний оцінювач найменших квадратів (ЗОНК) є функцією

з та (де позначає переміщення з ), що мінімізує суму квадратів залишків (суми непередбачуваних значень):

Тепер теорема стверджує, що оцінювач ЗОНК є СИНІМ. Основна ідея доказу полягає в тому, що оцінювач найменших квадратів не корелює з кожною лінійною неупередженою оцінкою нуля, тобто з кожною лінійною комбінацією коефіцієнти якої не залежать від неспостережуваного але очікуване значення якого завжди дорівнює нулю.

Зауваження

Доказ того, що ЗОНК справді МІНІМІЗУЄ суму суми квадратів залишків, може діяти наступним чином із розрахунком матриці Гесса та показуючи, що вона є позитивно визначеною.

Функція СКП (середньоквадратична похибка) яку ми хочемо мінімізувати, є

Для моделі множинної регресії з p змінними. Першка похідна -

,де X – матриця проектування

матриця Гессе інших похідних

Припускаючи стовпці є лінійно незалежними так, що є зворотнім, нехай , потім

Тепер нехай буде власним вектором .

З точки зору векторного множення це означає

де власне значення, що відповідає . Більше того,

Нарешті, як власний ветор був довільним, це означає що всі значення тому є позитивними є позитивно визначеним. Таким чином,

Є справді місцевим мінімумом.

Доказ

Дозволимо бути ще одним лінійним оцінювачем with де is a ненульова матриця. Оскільки ми обмежуємося неупередженими оцінювачами, мІнімальна середньоквадратична похибка передбачає мінімальну дисперсію. Отже, мета полягає в тому, щоб показати, що такий оцінювач має дисперсію, не меншу, ніж у ЗОНК оцінювача. Обчислюємо:

Тому, оскільки є не спостережуваною, є неупередженим якщо і тільки якщо . Потім:

Оскільки DD' є позитивною напіввизначеною матрицею, перевищує позитивну напіввизначену матрицю.

Зауваження щодо доказу

Як зазначалося раніше, стан є позитивною напіввизначеною матрицею, що еквівалентно властивості, якою є найкращий лінійний неупереджений оцінювач є (найкращий в тому сенсі, що він має мінімальну дисперсію). Щоб побачити це, нехай інший лінійний неупереджений оцінювач .

Більше того, рівність виконується якщо і тільки якщо . Обчислюємо

Це доводить, що рівність виконується якщо і тільки якщо що надає унікальність оцінювачу ЗОНК як СИНЬОМУ.

Узагальнювач оцінки найменших квадратів

Узагальнені найменші квадрати (УНК), розроблені Аіткеном,[5] розширюють теорему Гаусса-Маркова для випадку, коли вектор помилки має нескалярну коваріоційну матрицю.[6] Оцінювач Аіткена також є СИНІМ.

Теорема Гаусса-Маркова, як зазначено в економетриці

У більшості методів обчислення ЗОНК регресори (параметри, що цікавлять) у матриці проектування передбачають фіксування у повторних зразках. Це припущення вважається недоречним для переважно неекспериментальної науки, такої як економетрика.[7] Натомість припущення теореми Гаусса-Маркова висловлюється умовно .

Лінійність

Залежною змінною вважається лінійна функція змінних, зазначених у моделі. Специфікація повинна бути лінійною за своїми параметрами. Це не означає, що між незалежними та залежними змінними повинна існувати лінійна залежність. Незалежні змінні можуть приймати нелінійну форму, доки параметри є лінійними. Рівняння кваліфікується як лінійне може бути перетворене в лінійне шляхом заміни іншим параметром . Наприклад, рівняння з параметром, що залежить від незалежної змінної, не кваліфікується як лінійне , де є функцією .

Перетворення данних часто використовуються для перетворення рівняння в лінійну форму. Наприклад, функція Кобба-Дугласа - яка часто використовується в економіці, є нелінійною:

Але це можна виразити в лінійній формі, взявши натуральний логарифм обох сторін:[8]

Це припущення також охоплює питання специфікації: припускаючи, що вибрано відповідну функціональну форму і відсутні пропущені змінні.

Однак слід пам’ятати, що параметри, що мінімізують залишки перетвореного рівняння, не обов'язково мінімізують залишки вихідного рівняння.

Сувора екзогенність

Для усіх спостережень, очікування – залежно від регресорів – терміну помилки, дорівнює нулю:[9]

де вектор даних регресорів для i спостереження, а отже - це матриця даних або матриця проектування.

Геометрично з цього припущення випливає, що та є ортогональними один одному, так що їх внутрішній добуток (тобто поперечний момент) дорівнює нулю.

Це припущення порушується, якщо пояснювальні змінні є стохастичними, наприклад, коли вони вимірюються з помилкою, або є ендогенними.[10] Ендогенність може бути результатом одночасності, коли причинність протікає туди-сюди як між залежною, так і незалежною змінною. Для вирішення цієї проблеми зазвичай використовують інструментальні методи.

Повний ранг

Зразок матриці данних повинен мати повний ранг стовпця.

Syfrit не є оборотним, і оцінювач ЗОНК не може бути обчислений.

Порушенням цього припущення є досконала мультиколінеарність, тобто деякі пояснювальні змінні лінійно залежать. Один із сценаріїв, в якому це відбуватиметься, називається "фіксованою пасткою змінної", коли базова фіктивна змінна не опускається, що призводить до ідеальної кореляції між фіктивними змінними та постійним членом.[11]

Мультиколінеарність (якщо вона не є "ідеальною") може мати наслідком менш ефективну, але все ще неупереджену оцінку. Оцінки будуть менш точними та високочутливими до певних наборів даних.[12] Мультиколінеарність можна виявити за номером умови або коефіцієнтом дисперсії серед інших тестів.

Сферичні помилки

Зовнішній продукт вектора помилки повинний бути сферичним.

Це означає, що термін помилки має рівномірну дисперсію (гомоскедастичніть) і не має послідовної залежності.[13] якщо це припущення порушується, ЗОНК все ще є неупередженим, але неефективним. Термін "сферичних помилок" буде описувати багатовимірний нормальний розподіл: якщо у багатовимірній нормальній щільності, то рівняння - формула кульки з центром μ з радіусом σ у n-вимірному просторі.[14]

Гетероскедастичність виникає, коли кількість помилок співвідноситься з незалежною змінною. Наприклад, при регресії витрат на їжу та доходів помилка корелює з доходом. Люди з низьким рівнем доходу зазвичай витрачають подібну суму на їжу, тоді як люди з високим рівнем доходу можуть витратити дуже велику суму або стільки ж, скільки витрачають люди з низьким доходом. Гетероскедастичність також може бути причиною змін у практиці вимірювання. Наприклад, коли статистичні органи вдосконалюють свої дані, похибка вимірювання зменшується, тому термін помилки з часом зменшується.

Це припущення порушується, коли існує автокореляція. Автокореляція може бути візуалізована на графіку даних, коли дане спостереження, швидше за все, лежить вище встановленої лінії, якщо сусідні спостереження також лежать вище встановленої лінії регресії. Автокореляція є загальною для даних часових рядів, де ряд даних може відчувати "інерцію". Якщо залежній змінній потрібно деякий час, щоб повністю поглинути удар. Також може відбуватися просторова автокореляція, географічні райони можуть мати подібні помилки. Автокореляція може бути результатом неправильної специфікації, наприклад, вибору неправильної функціональної форми. У цих випадках виправлення специфікації є одним із можливих способів боротьби з автокореляцією.

За наявності сферичних помилок узагальнений оцінювач найменших квадратів може бути показаний СИНІМ.[6]

Див. також

Інша неупереджена статистика

- Найкраще лінійне неупереджене передбачення (НЛНП)

- Безсторонній оцінювач з мінімальною дисперсією (БОзМД)

Список літератури

- See chapter 7 of Johnson, R.A.; Wichern, D.W. (2002). Applied multivariate statistical analysis 5. Prentice hall.

- Theil, Henri (1971). Best Linear Unbiased Estimation and Prediction. Principles of Econometrics. New York: John Wiley & Sons. с. 119–124. ISBN 0-471-85845-5.

- Plackett, R. L. (1949). A Historical Note on the Method of Least Squares. Biometrika 36 (3/4): 458–460. doi:10.2307/2332682.

- David, F. N.; Neyman, J. (1938). Extension of the Markoff theorem on least squares. Statistical Research Memoirs 2: 105–116. OCLC 4025782.

- Aitken, A. C. (1935). On Least Squares and Linear Combinations of Observations. Proceedings of the Royal Society of Edinburgh 55: 42–48. doi:10.1017/S0370164600014346.

- Huang, David S. (1970). Regression and Econometric Methods. New York: John Wiley & Sons. с. 127–147. ISBN 0-471-41754-8.

- Hayashi, Fumio (2000). Econometrics. Princeton University Press. с. 13. ISBN 0-691-01018-8.

- Walters, A. A. (1970). An Introduction to Econometrics. New York: W. W. Norton. с. 275. ISBN 0-393-09931-8.

- Hayashi, Fumio (2000). Econometrics. Princeton University Press. с. 7. ISBN 0-691-01018-8.

- Johnston, John (1972). Econometric Methods (вид. Second). New York: McGraw-Hill. с. 267–291. ISBN 0-07-032679-7.

- Wooldridge, Jeffrey (2012). Introductory Econometrics (вид. Fifth international). South-Western. с. 220. ISBN 978-1-111-53439-4.

- Johnston, John (1972). Econometric Methods (вид. Second). New York: McGraw-Hill. с. 159–168. ISBN 0-07-032679-7.

- Hayashi, Fumio (2000). Econometrics. Princeton University Press. с. 10. ISBN 0-691-01018-8.

- Ramanathan, Ramu (1993). Nonspherical Disturbances. Statistical Methods in Econometrics. Academic Press. с. 330–351. ISBN 0-12-576830-3.

Джерела

- Davidson, James (2000). Statistical Analysis of the Regression Model. Econometric Theory. Oxford: Blackwell. с. 17–36. ISBN 0-631-17837-6.

- Goldberger, Arthur (1991). Classical Regression. A Course in Econometrics. Cambridge: Harvard University Press. с. 160–169. ISBN 0-674-17544-1.

- Theil, Henri (1971). Least Squares and the Standard Linear Model. Principles of Econometrics. New York: John Wiley & Sons. с. 101–162. ISBN 0-471-85845-5.

Посилання

- Earliest Known Uses of Some of the Words of Mathematics: G (коротка історія та пояснення назви)

- Proof of the Gauss Markov theorem for multiple linear regression (використовує матричну алгебру)

- Доказ теореми Гаусса — Маркова з використанням геометрії